항공영상을 통한 선박의 안벽으로부터 거리 및 자세 추정 기술 연구

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

This paper focuses on estimating the distance and status of ship during berthing and unberthing using Unmanned Aerial Vehicle (UAV). The goal is to develop a technology that estimates the distance and angle of the ship relative to the quay wall based on aerial images captured by UAV. The research subject is Pukyong National University's research vessel 'Nara,' and the berthing and unberthing process was measured to conduct the study. The aerial images captured by UAV are utilized for measuring the ship and quay wall using the YOLO (You Only Look Once) v8-seg computer vision-based deep learning model. The ship's pose within the image was estimated using Oriented Bounding Box (OBB) with the measured ship's point data. For quay wall line detection, methods based on the RANSAC (RANdom SAmple Consensus) algorithm and one-dimensional quay wall data linearization were compared and analyzed to determine the most effective approach. This process significantly enhances the ship's berthing and unberthing capabilities, supporting safe and efficient maritime transportation. This study provides important insights into ship position and pose estimation during the berthing process and suggests new directions for the development of UAV-assisted ship berthing technology.

Keywords:

Research vessel NARA, UAV(Unmanned Aerial Vehicle), YOLO(You Only Look Once), Berthing, OBB(Oriented Bounding Box), RANSAC(RANdom SAmple Consensus)키워드:

해양탐사선 나라호, 무인 항공기, 딥러닝 모델, 접안, 회전 경계 상자, 랜덤 샘플 합의1. 서 론

최근 무인 이동체에 대한 관심이 높아지면서 충돌 회피, 경제적 운항, 자동 이/접안 지원시스템, 이기종 간 협업 등의 연구가 활발히 이루어지고 있다. 특히, 선박의 자동 이/접안과 USV(무인 수상선)와 UAV(무인 항공기)의 협업은 각각 중요한 역할을 하며, 작업의 효율성과 범위를 확장하는 데 기여한다. 자동 이/접안 지원시스템은 선박 운항의 안전성과 정확성을 높이며, UAV와의 협업을 통해 보다 정밀하고 신속한 데이터를 제공할 수 있다. 예를 들어, 대형 선박의 이/접안 시 도선사가 UAV의 항공영상을 활용하면 선박과 주변 환경을 실시간으로 모니터링하여 이/접안 과정을 더 빠르고 안전하게 진행할 수 있다. 이처럼 무인 이동체 간의 협력은 복잡한 임무 수행에서 효율성, 안전성, 유연성을 제공하는 필수적인 접근 방식이며, 자동 이/접안 시스템과의 결합을 통해 더욱 안전하고 효과적인 해상 작업이 가능해진다.

무인 이동체의 협업에 관한 연구는 다음과 같다. UAV에 선박 식별 시스템을 탑재하여 항공기가 수집한 식별 정보를 전달하는 시스템에 관한 연구 (Choy et al., 2016), 인명 구조를 위해 UAV는 실시간 비디오 피드를 제공하며 Camshift 알고리즘과 윤곽선 감지 알고리즘을 사용한 시각적 위치 추정을 통해 USV의 항해를 보조하는 시스템에 관한 연구 (Dufek and Murphy, 2016), UAV로 촬영한 고해상도 이미지에서 선박을 효과적으로 감지하기 위해 형태기반 케스케이드와 자동 특징 추출을 결합한 알고리즘 개발에 관한 연구 (Dolgopolov et al., 2017), 혼잡한 항구와 수로에서 UAV에 장착된 RGB카메라와 GPS데이터를 결합하여 선박의 안전한 항해를 돕는 시스템에 관한 연구 (Sejersen et al., 2021) 등이 있다. Martinez (2022)는 호버링 중인 UAV의 단안 카메라를 통해 마커인식 기반 USV의 자세추정 시스템을 제시하였다. Cheng et al. (2023)은 USV의 상황 식별능력 개선을 위해 UAV에 탑재된 카메라에 딥러닝 모델을 적용하여 USV 주변 객체 인식에 관한 연구를 하였다. Tian et al. (2024)는 UAV가 USV에 도킹과정을 안정적으로 수행하기 위해 HHT-LSTM을 사용하여 USV의 운동을 예측에 관한 연구가 있다. 자동 이/접안 지원시스템에 관한 연구는 다음과 같다. 다중 LiDAR와 MMW 레이더의 센서 융합을 통해 안전한 접안 시스템 개발에 관한 연구(Wang and Zhang, 2022), 2D LiDAR를 통해 선박의 동적 접안 정보를 실시간으로 추적하고 안전한 접안을 보장하는 시스템을 제안하는 연구 (Chen and Li, 2023), 다수의 비전 센서를 사용하여 선박 접안을 위한 어라운드 뷰 모니터링 시스템에 관한 연구 (Kim et al., 2024), 3D LiDAR를 사용하여 선박의 위치와 자세를 추정하고, 접안선 방정식을 도출하여 정확한 접안 상태 정보 제공을 위한 연구 (Wang et al., 2024) 등이 있다.

본 연구는 UAV의 항공 영상을 통해 선박의 이/접안 과정 중 선박의 자세와 안벽으로부터의 거리를 추정하는 방법론을 제안한다. 기존의 연구들은 주로 UAV가 선박에 착륙하기 위해 UAV와 선박 간의 상대 위치 및 상대 각도를 추정하는 데 집중해왔다. 이번 연구는 항공 영상 데이터를 활용하여 선박의 안전한 이/접안을 보장하기 위해 선박의 자세와 안벽 사이의 거리를 추정하는 새로운 접근 방식을 도입하였다.

본 연구는 Kim et al. (2021)에서 횡방향속도 참조모형 개발과 Park and Lee (2020)에서 동적위치제어시스템을 활용한 횡이동 시험에서 사용된 국립부경대학교 탐사선 “나라호”의 이/접안 과정을 대상으로 진행되었으며, UAV로부터 촬영된 영상을 기반으로 하여 이루어졌다. 이러한 데이터를 처리하기 위해, Redmon et al. (2016)이 개발한 컴퓨터 비전 기반의 원스테이지 딥러닝 모델인 YOLO(You Only Look Once)를 사용하여 선박과 항만을 효과적으로 분류하고, 보다 정밀한 분류를 위해 세분화된 모델을 활용하였다. 이어서 선박의 자세를 추정하기 위해 검출된 포인트 데이터를 기반하여 주성분분석(PCA)을 적용하여 방향이 정의된 경계 상자(Oriented Bounding Box, OBB)를 생성하였다. 안벽으로부터의 거리 추정은 UAV 영상에서 검출된 항만 데이터를 활용하여 직선 검출 방법을 통해 안벽을 식별하고, 인식된 선박과의 거리를 측정하는 과정을 포함한다. 추정된 자세 데이터와 거리 데이터는 선박에 설치된 자세 계측 장치와 항만에 설치된 3D-LiDAR 시스템을 통해 검증되었다. 이러한 기술적 접근은 항공 영상 데이터를 활용하여 선박의 안전한 접안을 지원하며, 더욱 정확하고 신뢰성 있는 해상 운영을 가능하게 한다. 이 연구는 항공 영상을 통한 자동 이/접안 과정의 정확도를 높이는 데 중요한 기여를 하며, 해양 및 항만 분야에서의 응용 가능성을 제시한다.

2. 계측시험 준비

2.1 대상선박, 무인 항공기

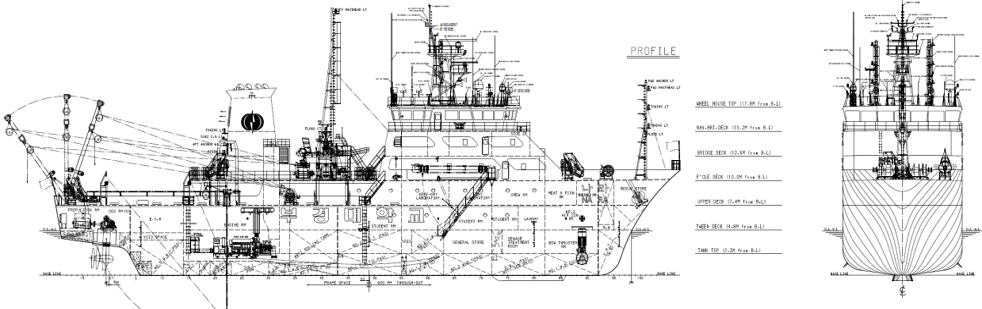

본 연구에서 항공영상을 통해 선박의 이/접안 과정을 계측하기 위해 부경대학교 해양탐사선 나라호의 이/접안 과정을 촬영하여 데이터를 취득하였다. 항공촬영을 위해 사용된 UAV의 모델은 연구실에서 기보유중인 DJI사의 Enterprise mavic 3T 모델이다. Fig. 1과 Table 1은 각각 나라호의 일반배치도와 주요 제원이며 Fig. 2과 Table 2은 실험에 사용된 UAV의 모습과 주요 제원이다.

2.2 좌표계

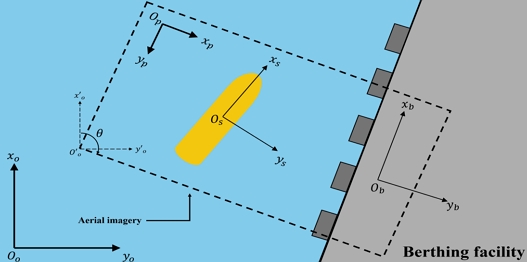

본 연구에서 선박의 각도를 추정하기 위해 사용된 좌표계는 Fig. 3과 같다. 항공영상 내의 픽셀 좌표계 Op - xpyp와 지구 고정 좌표계 Oo - xoyo, 선박 고정 좌표계 Os - xsys, 안벽 고정 좌표계 Ob - xbyb가 사용되었다. 본 연구에서 기준이 되는 좌표계는 지구 고정 좌표계로 픽셀 좌표계에서 선박과 안벽의 각도를 계산한 후 이를 지구 고정 좌표계로 변환하기 위해 두 좌표계 간의 각도 차이를 보정하는 과정이 필요하다. 이를 위해 드론의 자세(θ)를 기반으로 픽셀 좌표계와 지구 고정 좌표계 사이의 각도 차이를 측정하였으며 이후 식 (1), (2)와 같이 픽셀 좌표계에서 계산된 선박의 각도()와 안벽의 각도()에 이 각도 차이를 더하여 지구 고정 좌표계(θs,θb)로 변환하였다.

| (1) |

| (2) |

3. 선박의 자세, 위치 추정 및 안벽 검출

3.1 항공 영상을 활용한 선박 및 안벽 인식

본 연구에서는 UAV를 상공에 호버링한 상태에서 촬영한 항공 영상을 통해 선박과 안벽을 인식하였다. 이를 위해 딥러닝 모델인 YOLOv8-segmentation을 사용하였으며 모델 선정에 앞서 관련 연구 (Spakota et al., 2024)에서 YOLOv8과 Mask R-CNN의 성능 비교 결과를 참조하였다. 해당 연구에서는 YOLOv8이 빠른 연산 속도와 경량화된 구조로 실시간 처리에 적합하며 픽셀 단위 경계를 예측하여 객체를 세분화하는 데 효율적인 것으로 나타났다. Mask R-CNN은 높은 정확도를 지닌 모델이나 두 단계의 연산 과정으로 인해 실시간 처리에 제약이 있을 수 있으며, 실제 성능 차이는 미미해 체감하기 어렵다는 점이 언급되었다. Table 3은 복잡한 인식 상황에서의 2가지의 세분화 모델(YOLOv8, Mask R-CNN)의 성능을 지표로 나타내어 비교한 것이다.

Summary of the performance metrics of YOLOv8 and Mask R-CNN models including precision, recall, mAP@0.5, inference times, and FPS for single and multi-class object segmentation tasks (Spakota et al., 2024)

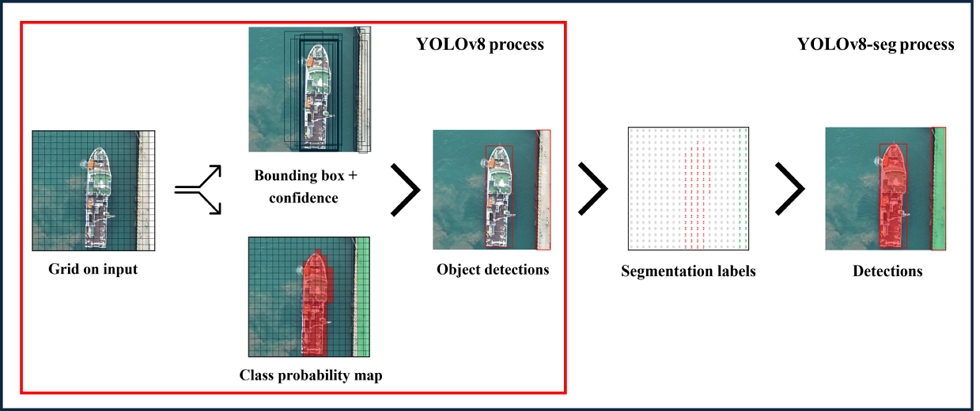

YOLOv8-segmentation 모델은 일반 YOLOv8 모델이 객체 탐지를 위해 경계 박스(Bounding box, Bbox)를 생성하는 것과 달리, 각 객체의 정확한 픽셀 단위 경계를 예측하여 각 픽셀이 객체에 속하는지 여부를 판단한다. 이러한 이미지 세분화 모델은 의료, 자율주행, 위성 이미지 분석 등 다양한 분야에서 널리 활용되고 있다. 세분화가 없는 YOLOv8 모델의 경우 입력 이미지를 S×S 크기로 격자로 나눈 후, 경계박스에 대한 예측과 클래스 확률 예측을 동시에 진행하는 원스테이지 방식의 딥러닝 모델로 매우 빠른 속도로 객체를 탐지가 가능하다. 예측된 경계박스 중에서 중복된 박스를 제거하고, 가장 높은 확률의 박스만 남기는 후처리 기법인 NMS(Non-Maximum Suppression)을 사용하여 모델이 정확하게 객체를 탐지하고 분류할 수 있도록 한다. YOLOv8 모델의 객체 탐지 과정은 Fig. 4과 같다. YOLOv8-segmentation과 같은 인스턴스 세분화 모델의 경우 단일단계 모델로써 탐지 과정과 개별 객체에 대한 세분화 마스크를 탐지하고 함께 진행되어 빠르게 객체를 탐지하고 분할할 수 있어 실시간으로 이미지를 처리하기에 용이하다.

3.2 안벽 검출 과정

본 연구에서는 항공영상을 활용하여 항만을 인식하고, 선박 접안부 외벽과 안벽 사이의 거리를 추정하기 위해 안벽을 검출하였다. 안벽 검출은 두 가지 방법으로 시도되었다. 첫 번째 방법은 항공영상을 통해 항만을 인식한 후, Fischler and Bolles (1981)이 제시한 RANSAC 알고리즘을 사용하여 안벽 라인을 추출하는 것이며, 두 번째 방법은 인식된 항만 데이터를 1차원화하여 안벽을 검출하는 방식이다. 두 방법을 모두 적용한 후 비교하여, 정확도 및 데이터의 안정성이 높은 방법을 최종적으로 선택하였다.

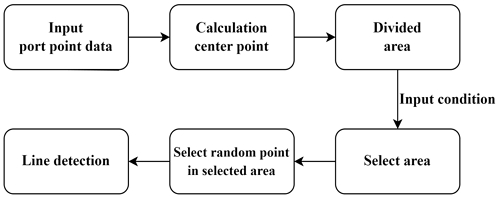

RANSAC은 데이터를 랜덤하게 샘플링하여 모델을 피팅한 후, 피팅 결과가 목표치에 도달했는지 확인하여 모델을 최적화하는 알고리즘이다. 본 연구에서는 항공영상을 YOLO로 분석해 항만을 인식하고, 이 인식된 포인트 데이터에 RANSAC 알고리즘을 적용하여 안벽 라인을 검출하였다. 전체 항만 데이터에 직접 RANSAC 알고리즘을 적용하면 의도와 다른 라인이 검출될 수 있어, Fig. 5에 나타난 과정을 통해 안벽 라인을 검출하였다. 먼저 인식된 항만 데이터의 평균 값을 계산하고, 이를 기준으로 데이터를 4개의 영역으로 나눈 다음, 선박이 항만의 좌측에 위치한 경우 좌측 2개의 영역을 선택한다. 선택된 영역에서 각각 하나의 점을 랜덤으로 선택하여 직선을 검출하는 방식이다.

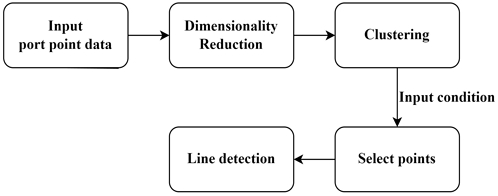

두 번째 방식은 항만 포인트 2차원 데이터를 1차원 데이터로 차원축소하여 직선을 검출하는 방법이다. 항만 인식 데이터는 영상에서 얻어진 2차원 데이터(x,y)로 구성되는데, 이 중 y값을 기준으로 데이터를 1차원으로 축소한 후 클러스터링을 수행한다. 이후, 클러스터링 결과를 다시 x값과 결합하여 원하는 포인트를 추출한다. Fig. 6은 이 두 번째 방식의 과정을 시각적으로 나타낸 것이다.

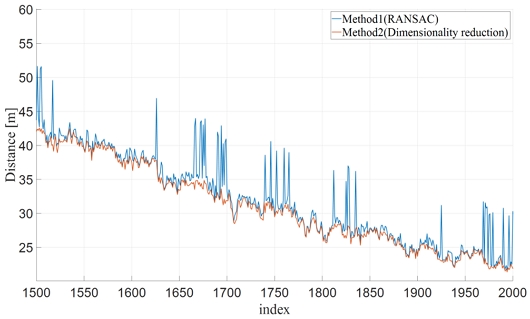

안벽과 선박 사이의 거리를 비교적 정확한 추정을 위해 두 가지 방법을 비교하였다. 첫 번째 방법인 RANSAC을 이용한 경우, 포인트 데이터를 랜덤으로 샘플링하기 때문에 매 프레임마다 다른 직선을 검출하여 거리 추정 데이터에 많은 노이즈가 발생한다. 반면, 두 번째 방법은 조건에 맞는 점을 직접적으로 샘플링하여 데이터의 변동성이 적다. 따라서 본 논문에서는 거리 데이터 추정시 변동성이 적은 두 번째 방법인 데이터 2차원 데이터를 차원감소하는 방법을 사용하였다. Fig. 7은 두 가지 방법으로 추정한 거리 데이터의 일정 부분의 비교를 보여주며 Fig. 8은 두 가지 방법을 통해 안벽 라인을 검출한 모습을 보여준다.

3.3 선박의 자세 추정

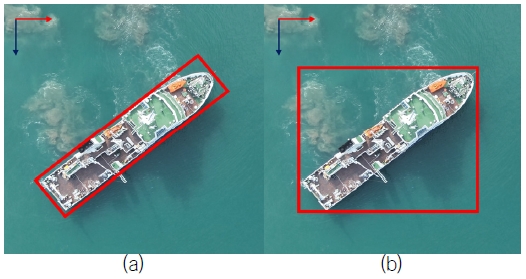

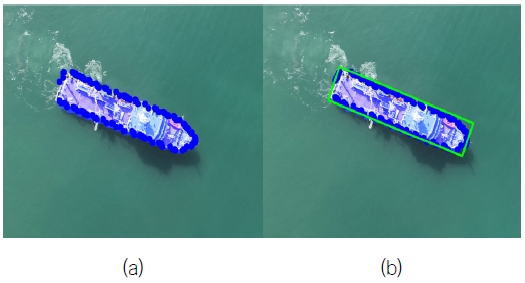

딥러닝 모델을 통한 선박 세분화 검출 후 Yi et al. (2021)이 제시한 방법론을 착안하여 OBB를 통해 자세를 추정하였다. OBB란 경계박스의 한 유형으로, 축에 정렬되지 않은 객체를 더 정확하게 감싸는 경계박스이다. 일반적으로 객체 탐지시 사용하는 축 정렬 경계박스인 AABB(Axis-Aligned Bounding Box)는 이미지의 축에 평행한 직사각형을 사용하여 객체를 탐지하지만, OBB는 객체의 방향에 맞추어 회전된 직사각형을 사용한다. Fig. 9는 AABB와 OBB의 경계박스에 대한 차이를 나타낸 것이다.

딥러닝 모델을 통해 검출한 선박의 포인트 데이터를 이용하여 주성분 분석(PCA, Principal Component Analysis)의 주요 개념을 사용하여 OBB를 생성하였다. 주성분 분석은 데이터의 주요 변동성을 설명하는 방향을 찾는 기법으로, 데이터의 차원을 축소하고 더 중요한 특성을 추출하는 데 주로 사용된다. 주성분 분석을 통한 OBB생성과정에 대해 설명하겠다.

Fig. 10(a)과 같이 딥러닝 모델을 통해 예측된 마스크의 포인트 좌표를 식 (3)을 통해 평균값을 구한다. 식 (3)에서의 n은 포인트 데이터의 개수이며 Pi 는 포인트 데이터의 행렬이다.

| (3) |

The appearance of a ship recognized during the berthing process, without an OBB applied(a), and with an OBB applied(b)

다음은 점들의 분산을 나타내며, 각 축에 대한 데이터의 분포를 확인할 수 있는 공분산 행렬을 구한다. 식 (3)을 통해 계산된 중심점을 통해 공분산 행렬을 식 (4)와 같이 산출한다.

| (4) |

식 (4)를 통해 계산된 공분산 행렬을 통해 고유값과 고유벡터를 계산한다. 식 (5)에서의 λ 는 고유값을 나타내며 분산의 크기를 나타낸다. v 는 고유벡터를 나타내고 분산의 방향을 나타낸다. 데이터가 가장 많이 퍼져 있는 방향을 주축으로 삼는다.

| (5) |

식 (6)과 (7)은 포인트 좌표 집합(P)을 주축(λ1)과 보조축(λ1)에 투영한 것을 나타낸다. 투영된 값들은 주축과 보조축에 따른 새로운 좌표값을 제공한다.

| (6) |

| (7) |

식 (8), (9)를 통해 투영된 값들의 최솟값과 최댓값을 계산하고 식 (10)을 통해 OBB의 모서리 좌표를 계산한다. 모서리 좌표는 기본적으로 주축과 보조축의 스케일링과 중심 점 이동을 통해 계산된다. 은 min1, max1 값을 가지고 는 min2, max2 값을 가진다. 위 과정을 통해 계산된 OBB의 그림은 Fig. 10(b)와 같이 나타내었다.

| (8) |

| (9) |

| (10) |

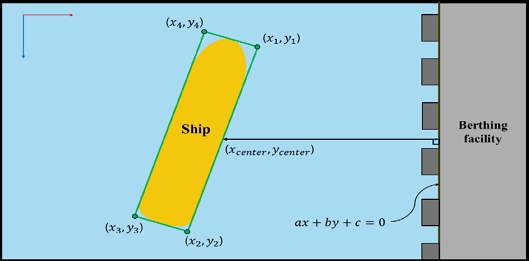

3.4 선박의 안벽으로부터의 거리 추정

위 과정에서 산출한 OBB와 검출한 안벽의 직선방정식을 통해 선박과 안벽간의 거리를 추정하였다. 선박기준 접안면인 선박의 오른쪽 외벽과 안벽과의 거리를 추정하였다. OBB의 스타보드 선미, 선수쪽 좌표의 평균 좌표와 안벽 검출 시 산출하였던 직선방정식의 최소 거리를 식 (11)을 통해 계산하였다. a, b, c는 안벽 검출 과정에서 산출된 계수이며 선박의 오른쪽 외벽 중심점(xcenter, ycenter)은 OBB를 통한 오른쪽 외벽의 선수, 선미 좌표를 평균한 것이다. 중간점을 선택한 이유는 인식 기반 측정 특성상 선수와 선미 부분의 위치가 정확하게 인식되지 않을 가능성이 있어 중심점을 기준으로 측정할 경우 회전이나 기울기 변화에 따른 거리 데이터의 불필요한 변동을 줄이고 일관성을 확보할 수 있기 때문이다. Fig. 11은 거리도출 과정을 시각화한 것이다.

| (11) |

| (12) |

| (13) |

위 식 (12)과 (13)을 통해 산출된 거리 값의 단위는 픽셀단위이다. 이를 미터 단위로 변환하기 위해, 앞서 설명한 나라호의 주요 제원을 활용하였다. 먼저, 나라호의 길이와 폭을 각각 픽셀 단위로 계산한 후, 이를 실제 나라호의 길이와 폭으로 나누어 픽셀 단위를 미터 단위로 변환하였다. 이 변환 과정을 통해 최종적으로 배와 안벽 간의 거리를 미터 단위로 계산하였다.

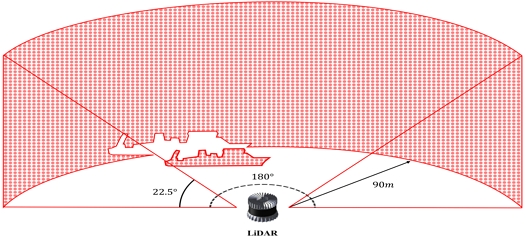

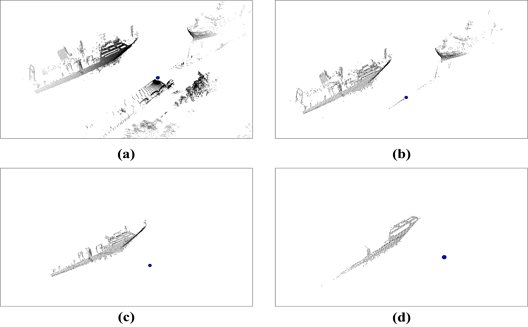

본 연구에서는 항공영상을 통해 계산된 선박과 안벽간의 거리계측 데이터를 검증하기 위해 3D-LiDAR를 사용하였다. 데이터계측을 위해 사용된 3D-LiDAR는 OUSTER사의 OS1모델로 LiDAR의 스펙은 Table 4과 같다. 안벽에 LiDAR를 설치하여 Fig. 12과 같이 배를 계측하고 계측한 데이터를 후처리하여 배와 안벽 간의 거리를 계측하였다.

LiDAR데이터 전처리는 Fig. 13과 같은 과정으로 진행하였다. 3D-LiDAR 데이터의 로우데이터를 수신한 후 해상환경에 대한 데이터만 받을 수 있도록 LiDAR데이터의 범위를 제한하였다. 제한한 데이터를 유클라디안 거리 군집화 알고리즘을 사용하여 군집화를 진행하였다. 선박기준 접안외벽을 탐지하기위해 클러스터링한 데이터를 RANSAC알고리즘을 사용하여 평면검출을 진행하였다. 군집화, 평면검출 진행 시 사용한 파라미터는 Table 5와 같다.

3D-LiDAR data post-processing, input raw data(a), filter point cloud(b), clustering point cloud(c), detect plan(d)

4. 결과 및 분석

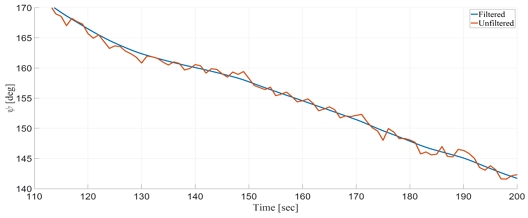

본 연구에서는 데이터 검증 이전 항공영상을 통해 추정한 자세 데이터에 발생한 많은 노이즈를 줄이기 위해 Butterworth (1930)가 제안한 저역 통과 필터를 사용하였다. Butterworth 저역 통과 필터는 신호 처리에서 특정 주파수 이하의 신호를 통과시키고 그 이상의 주파수를 감쇠시키는 필터이다. 이 필터는 통과 대역에서의 주파수 응답이 매우 평탄하여 진동이 없고, 차단 주파수 이후에는 신호를 서서히 감쇠시킨다. 이러한 특성 덕분에 Butterworth 필터는 신호의 왜곡을 최소화하면서 불필요한 노이즈를 제거하는 데 사용된다. 식 (12)은 Butterworth 필터의 주파수 응답 함수를 구하는 식을 나타낸다. fs는 샘플링 주파수로, 데이터가 수신되는 주파수를 의미한다. fc는 차단 주파수로, 필터가 낮은 주파수 신호를 통과시키고 높은 주파수 신호를 감쇠시키기 위해 설정한 주파수이다. n은 필터의 차수로, 필터의 급격한 변화 정도와 성능을 결정하는 매개변수이다. 본 연구에서는 필터 차수와 차단 주파수는 시행착오적 방법을 통해 평균 제곱근 오차가 가장 작은 값으로 결정하였다. Fig. 14는 필터 적용 전후 데이터를 시각화 한 것이다.

| (12) |

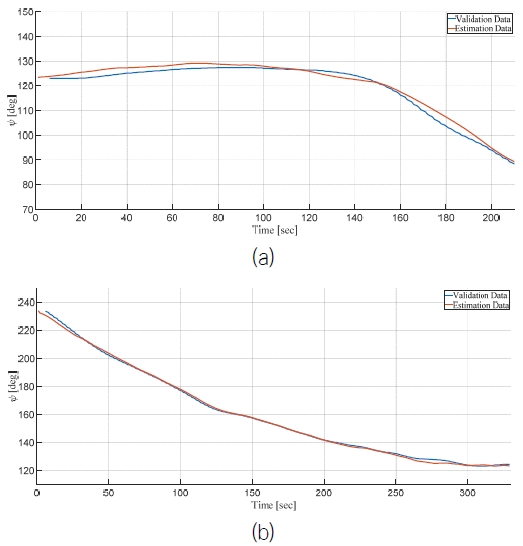

제안된 자세 및 거리 추정 연구의 성능을 평가하기 위해 실제 접안 및 이안하는 나라호를 대상으로 필드 테스트를 수행하였다. 실험은 2024년 5월10일, 17일, 7월 22일, 24일 총 4일에 걸쳐 용호부두에서 진행되었다. Fig. 15는 나라호가 이/접안시 센서로 취득한 자세데이터와 추정한 데이터를 비교한 그림이다.

A graph comparing the validation pose data(device onboard NARA) with the estimated pose data, unberthing proces(a), berthing process(b)

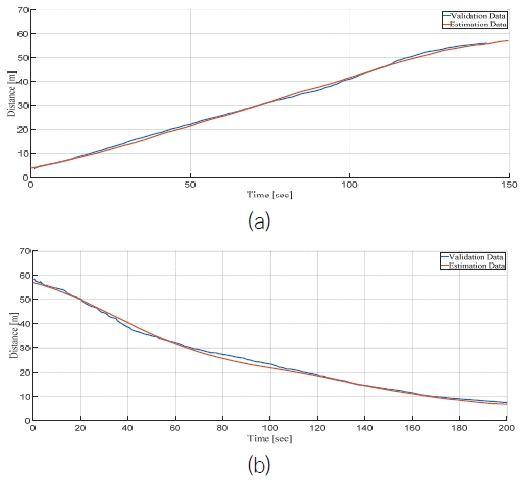

본 연구에서는 안벽과 선박의 이/접안 과정에서 외벽 간 거리를 추정하였다. 추정한 데이터의 유효성을 검증하기 위해 Fig. 12과 같이 안벽에 LiDAR를 설치하여 선박의 거리를 측정하엿다. Fig. 16는 나라호가 이/접안할 때 LiDAR로 측정한 안벽과 나라호 외벽 사이의 거리 데이터와 항공 영상을 통해 추정한 데이터를 비교한 것이다.

A graph comparing the validation distance data (LiDAR installed in the port) with the estimated distance data, unberthing proces(a), berthing process(b)

Table 6의 결과를 살펴보면, 총 4회 수행한 실험 중 최대 평균 거리오차는 1.6034[m], 최소 평균 거리오차는 0.7435[m]이며, 평균 자세오차는 최대 1.8521[deg], 최소 0.8408[deg]로 나타났다. 이는 본 연구의 성능이 현재 상용화 되어있는 자세계측장치와 3D-LiDAR를 대체할 수 있는 가능성을 보여주고 있다.

5. 결 론

본 논문은 UAV 영상을 활용하여 선박의 이/접안 과정에서 자세와 안벽으로부터의 거리를 추정하는 새로운 접근을 제안하였다. 이 방법은 기존의 측정 시스템을 대체하는 것도 가능하지만 UAV 영상을 통해 이/접안 전 과정을 광범위한 관점에서 모니터링함으로써 선박과 주변 환경을 효과적으로 파악할 수 있는 점에서 차별화된다. 이러한 전반적 시야 호가보는 이/접안 과정의 효율성과 안전성을 높이는 데 기여할 수 있으며 타선과의 거리 판단이나 자율운항 지원 등 기존 시스템의 확장에도 유용하게 활용될 수 있다. 본 연구의 결과는 UAV 기반 영상 분석을 통해 해상 운항의 안전성을 증대시키고 자율운항 보조 시스템으로서의 가능성을 제시하는 데 의미가 있다.

Acknowledgments

이 논문(또는 저서)은 국립부경대학교 자율창의학술연구비(2024년)에 의하여 연구되었음

References

- Butterworth, S., 1930. On the theory of filter amplifiers. Wireless Engineer, 7, pp.536–541.

-

Chen, C. and Li, Y., 2023. Real-time tracking and dynamic berthing information extraction system with 2D LiDAR data. Ocean Engineering, 276, 114181.

[https://doi.org/10.1016/j.oceaneng.2023.114181]

-

Cheng, C., Liu, D., Du, J.-H. and Li, Y.-Z., 2023. Research on visual perception for coordinated air–sea through a cooperative USV-UAV system. Journal of Marine Science and Engineering, 11, 1978.

[https://doi.org/10.3390/jmse11101978]

-

Choy, S., Ko, Y. and Kang, Y., 2016. Development of ship identification and display system using unmanned aerial vehicle system. Journal of the Korean Society for Aeronautical & Space Sciences, 44, pp.862–870.

[https://doi.org/10.5139/JKSAS.2016.44.10.862]

-

Dufek, J. and Murphy, R., 2016. Visual pose estimation of USV from UAV to assist drowning victims recovery. Proceedings of the IEEE International Symposium on Safety, Security, and Rescue Robotics (SSRR), Lausanne, Switzerland, pp.147–153.

[https://doi.org/10.1109/SSRR.2016.7784291]

-

Fischler, M.A. and Bolles, R.C., 1981. Random sample consensus: A paradigm for model fitting with applications to image analysis and automated cartography. Communications of the ACM, 24, pp.381–395.

[https://doi.org/10.1145/358669.358692]

- Kim, H., Kim, D., Park, B. and Lee, S.-M., 2020. Vision sensor and deep learning-based around view monitoring system for ship berthing. IEMEK Journal of Embedded Systems and Applications, 15, pp.71–78.

-

Kim, J.-H., Jo, H.-J., Kim, S.-R., Lee, J.-H. and Park, J.-Y., 2021. A study on development of sway velocity reference model during auto-berthing/unberthing through analysis of ship’s berthing/unberthing data. Journal of the Society of Naval Architects of Korea, 58, pp.358–365.

[https://doi.org/10.3744/SNAK.2021.58.6.358]

-

Le Fevre Sejersen, J., De Figueiredo, R.P. and Kayacan, E., 2021. Safe vessel navigation visually aided by autonomous unmanned aerial vehicles in congested harbors and waterways. Proceedings of the IEEE 17th International Conference on Automation Science and Engineering (CASE), Lyon, France, pp.1901–1907.

[https://doi.org/10.1109/CASE49439.2021.9551637]

- Martinez Macias, M.A., 2022, USV attitude position estimation by a hovering UAV using monocular images of deck-mounted lights. Master of Science in Engineering Sciences (Mechanical Engineering), University of California San Diego.

-

Park, J.-Y. and Lee, J.-H., 2020. A study on full-scale crabbing test using dynamic positioning system. Journal of the Society of Naval Architects of Korea, 57, pp.345–352.

[https://doi.org/10.3744/SNAK.2020.57.6.345]

-

Redmon, J., Divvala, S., Girshick, R. and Farhadi, A., 2016. You only look once: Unified, real-time object detection. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA, pp.779–788.

[https://doi.org/10.1109/CVPR.2016.91]

-

Sapkota, R., Ahmed, D. and Karkee, M., 2024. Comparing YOLOv8 and Mask R-CNN for instance segmentation in complex orchard environments. Artificial Intelligence in Agriculture, 13, pp.84–99.

[https://doi.org/10.1016/j.aiia.2024.07.001]

-

Tian, E., Li, Y., Liao, Y. and Cao, J., 2024. UAV-USV docking control system based on motion compensation deck and attitude prediction. Ocean Engineering, 307, p.118223.

[https://doi.org/10.1016/j.oceaneng.2024.118223]

-

Dolgopolov, A.V., Kazantsev, P.A. and Bezuhliy, N.N., 2017. Ship detection in images obtained from the unmanned aerial vehicle (UAV). Indian Journal of Science and Technology, 9.

[https://doi.org/10.17485/ijst/2016/v9i46/107562]

-

Wang, H., Yin, Y., Jing, Q., Xiao, F. and Cao, Z., 2024. A berthing state estimation pipeline based on 3D point cloud scan-matching and berth line fitting. Measurement, 226, p.114196.

[https://doi.org/10.1016/j.measurement.2024.114196]

-

Wang, Z. and Zhang, Y., 2022. Estimation of ship berthing parameters based on Multi-LiDAR and MMW radar data fusion. Ocean Engineering, 266, p.113155.

[https://doi.org/10.1016/j.oceaneng.2022.113155]

-

Yi, J., Wu, P., Liu, B., Huang, Q., Qu, H. and Metaxas, D., 2021. Oriented object detection in aerial images with box boundary-aware vectors. Proceedings of the IEEE Winter Conference on Applications of Computer Vision (WACV), Waikoloa, HI, USA, pp.2149–2158.

[https://doi.org/10.1109/WACV48630.2021.00220]