무인수상선의 디지털 트윈 공간 재구성을 위한 이미지 보정 및 점군데이터 간의 매핑 프레임워크 설계

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

In this study, we present a mapping framework for 3D spatial reconstruction of digital twin model using navigation and perception sensors mounted on an Autonomous Surface Vehicle (ASV). For improving the level of realism of digital twin models, 3D spatial information should be reconstructed as a digitalized spatial model and integrated with the components and system models of the ASV. In particular, for the 3D spatial reconstruction, color and 3D point cloud data which acquired from a camera and a LiDAR sensors corresponding to the navigation information at the specific time are required to map without minimizing the noise. To ensure clear and accurate reconstruction of the acquired data in the proposed mapping framework, a image preprocessing was designed to enhance the brightness of low-light images, and a preprocessing for 3D point cloud data was included to filter out unnecessary data. Subsequently, a point matching process between consecutive 3D point cloud data was conducted using the Generalized Iterative Closest Point (G-ICP) approach, and the color information was mapped with the matched 3D point cloud data. The feasibility of the proposed mapping framework was validated through a field data set acquired from field experiments in a inland water environment, and its results were described.

Keywords:

Autonomous Surface Vehicle(ASV), 3D spatial information, Mapping framework, Sensor calibration, Generalized Iterative Closest Point(G-ICP)키워드:

무인수상선, 3차원 공간 정보, 매핑 프레임워크, 센서 캘리브레이션1. 서 론

자율운항선박 기술 개발에 관한 연구가 활발하게 진행되면서 개발 기술의 현재 수준과 성능을 검증하기 위한 실해역에서의 실증 성능 검증이 진행되고 있다. 자율운항선박이 입출항하는 과정을 포함한 운항하는 전 과정에서 성능을 검증하는데, 안전을 비롯한 시간적·환경적·상황적 한계로 인하여 제한된 상황에서 성능 검증이 이루어지고 있다. 특히, 외해에서 단계적으로 성능이 검증된 개발 기술을 항만이나 연안과 같은 공간적 복잡도가 높은 해역에 바로 적용하기에는 운항 안전의 위험 요소가 많아 현실적으로 어렵다. 따라서, 이를 보조하기 위한 수단으로 실제 선박 및 시스템을 가상의 공간에서 모사하여 예지보전 및 유지보수 측면의 효용성을 높이기 위한 디지털 트윈(digital twin) 기술의 활용 방안이 제시되고 있다 (Madusanka et al., 2023). 디지털 트윈 기술에 포함된 선박과 시스템의 단위 모델뿐만 아니라 현실적인 3차원 공간 정보가 반영된 디지털 트윈 기술이 구현된다면, 심층적 기술 검증의 체계를 구축할 수 있다.

기존 대부분 선박 운항 시뮬레이터 상에서의 공간 정보는 인위적으로 개발된 구조물이나 선박 등의 도면과 같은 객체 정보를 토대로 3차원 공간 모델을 생성한다. 반면, 디지털 트윈 기술은 현실 환경과 동일한 가상 환경을 모사하는 것을 전제하므로, 확보가 가능한 다차원적 공간 정보를 기반한 현실적 3차원 공간 정보를 구축하는 것이 필요하다. 구축된 3차원 공간 정보는 자율운항선박의 자율적 운항에 필요한 상황인식 정보를 기반하여 재생성 (Joung et al., 2009)하거나 운항 경로상에 잠재된 위험 요소(해상 구조물, 방파제, 암초 등)를 전자해도상에 표기된 정보와의 비교를 통해 상황인식 및 자율운항 기술의 성능을 단계적으로 검증하는 데 활용할 수 있다. 이외에, 정밀한 3차원 공간 정보를 토대로 선박의 자율운항 과정에서 GNSS 수신 제약이나 항법 시스템의 일시적 오류에 대체할 수 있는 비상 상황 사고 대응 기술로도 확장할 수 있다.

디지털 트윈 기술 구현을 위한 3차원 공간 정보는 일반적으로 선박의 자율운항을 위해 기본적으로 탑재되는 항법 및 카메라, 라이다, 레이더 등을 동시 복합적으로 활용하여 확보한 데이터를 기반으로 생성할 수 있다. 레이더는 카메라 및 라이다 대비 해상도가 낮아 3차원 정보를 생성하는데 한계가 있으나, 카메라는 인간의 시각 정보를 대체할 수 있는 유일한 센서로, 높은 해상도로 객체의 색상을 포함한 상태 정보를 식별할 수 있다. 그리고 RGB-D 카메라는 이미지상의 각 픽셀의 색상 정보와 깊이 정보를 포함하고 있어 객체의 색상과 거리 정보를 확인할 수 있으며 하나의 장면을 3차원으로 표현할 수 있다. 그러나 깊이 정보를 계측하는 데 상대적 거리의 한계가 있으며 동시에 조도 변화에 민감하며, 조도 변화에 따른 인식 정확도에 큰 영향을 받는 한계가 있다 (Wang, 2021). 반면, 라이다의 점군데이터(PCD, Point Cloud Data)는 3차원 공간 정보를 포함하므로 인식한 객체의 자세와 형상 정보로 변환하는데 카메라에 비해 용이한 이점이 있다. 그러나 점군데이터의 분포는 스캐닝 중심에서 멀어질수록 점점 희소해지므로 근거리에 비해 원거리에 위치한 객체를 인식하는데 한계가 있다 (Zhao et al., 2020). 따라서, 각 센서가 가지고 있는 특성을 상호 보완적으로 고려하고, 각 센서의 고유 잡음을 최소화하는 전처리 과정을 통해 3차원 공간 정보를 생성하는 연구들이 수행된 바 있다.

수면 위를 감지하는 라이다, 카메라, 레이더와 수면 아래를 감지하는 이미징 소나가 장착된 수상선을 사용하여 수면 위와 아래를 모두 매핑하는 연구 (Leedekerken et al., 2010)가 수행된 바 있다. 이 연구에서는 수면 위의 구조물을 매핑하기 위해 세 개의 2차원 라이다를 이용하여 짧은 시간 동안 정밀한 해상도로 옥트리(octree)를 구성한 서브맵을 생성하고, IMU 데이터를 사용하여 교량과 선착장에서 흔히 볼 수 있는 객체에 대한 표면 법선 추정의 복잡성을 고려하여 point-to-point Iterative Closest Point(ICP)기법을 사용하여 매핑을 수행하였다. Feixiang and Jiandao (2019)는 자율운항선박의 안전한 항해를 위해 라이다의 점군데이터를 활용하여 부표의 표면을 3차원 형상으로 재구성하는 연구를 수행하였다. 이 연구에서는 항해 과정에서 라이다로 항상 부표를 스캐닝하며 점군데이터 라이브러리(PCL, Point Cloud Library)를 기반한 점군데이터의 밀도화 알고리즘을 통해 점군데이터의 두 프레임을 정렬하고 ICP 기법을 적용하여 3차원 형상을 재구성하였다. 또한, 3차원 라이다와 Multibeam Echosounder (MBES)를 사용하여 해상 풍력 발전 단지 인프라가 형성된 다중 영역을 매핑하는 연구 (Campos et al., 2020)에서는 수면 위의 매핑을 위해 GPS 및 IMU의 융합을 통해 정확한 주행 거리를 측정하고 라이다의 점군데이터 필터링 및 Levenberg Marquardt-ICP 기법으로 실시간 환경을 재구성하였다. Sattler et al. (2022)는 해양 상황을 모니터링하고 상황인식 성능을 개선하기 위한 3차원 환경 재구성을 위해 스테레오 카메라로부터 얻은 두 개의 이미지를 사용하여 객체를 탐지 및 분할과 깊이 추정 등을 수행하여 3차원 점군데이터를 생성하고 재구성하였다. Jung et al. (2023)은 해상 파력 발전소의 수면 위와 아래 하부 구조 정보를 각각 획득하기 위한 무인수상선을 개발하여 라이다와 MBES를 사용하여 매핑 시스템을 구현하였다. 수면 위의 발전소를 매핑하기에 앞서 원치 않은 점군데이터를 제거하기 위해 pass through 필터를 적용하였고, 희소한 라이다 점군데이터를 보존하기 위해 서브맵을 생성하여 Radius Outlier Removal(ROR) 필터를 적용하여 발전소를 매핑하는 연구가 수행된 바 있다.

본 연구에서는 디지털 트윈 기술 구현에 필요한 요소 모델 중 3차원 공간 모델을 생성하기 위해 무인수상선에 탑재된 항법 센서 및 카메라와 라이다 기반의 매핑 프레임워크를 제안하였다. 카메라 및 라이다 데이터에 포함된 고유의 잡음을 최소화하는 전처리 기법을 적용하였으며, 특히 수상 구조물에 인접할수록 카메라 이미지의 조도가 변하는 상황에 대응하기 위한 이미지 전처리 기법을 구현하였다. 그리고 카메라 및 라이다 간의 캘리브레이션을 통한 색상 정보를 점군데이터에 투영하고, 점군데이터 간의 불확실성 요소를 고려한 Generalized-ICP(G-ICP) 기법을 적용하여 색상 정보가 포함된 3차원 공간 정보로 매핑하였다. 설계한 매핑 프레임워크의 적용 가능성을 검증하기 위하여 내수면 환경에서 자율적 운항이 가능한 무인수상선을 개발 및 운용하여 확보한 데이터에 적용하고, 그 결과를 기술하였다.

2. 3차원 공간 정보 매핑 기법

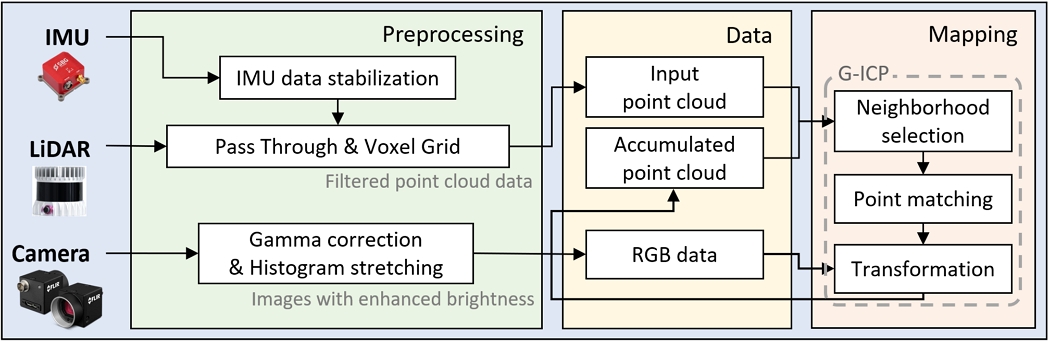

무인수상선에 탑재된 카메라 및 라이다의 데이터를 활용하여 3차원 공간 정보를 매핑하는 프레임워크 구조는 Fig. 1과 같다. 카메라 및 라이다 데이터 간의 기하학 정보를 확보하기 위해 카메라-라이다 캘리브리이션을 수행하였으며, 저조도 환경에서 획득한 이미지의 밝기를 보정하기 위한 이미지 전처리 기법과 라이다의 점군데이터 상에 포함된 잡음을 최소화하기 위한 전처리 기법을 매핑 프레임워크에 적용하였다. 그리고 연속된 점군데이터 간의 기하학 정보를 매핑하여 3차원 공간 정보를 생성한다.

Flowchart of camera-LiDAR preprocessing and 3D registration using G-ICP for 3D spatial reconstruction

2.1 카메라 및 라이다 캘리브레이션

카메라의 색상 정보를 라이다의 점군데이터에 투영시키기 위해서는 두 센서 간의 기하학 정보가 필요하며, 카메라 자체의 왜곡을 포함한 내부 고유 파라미터 정보를 얻기 위하여 캘리브레이션을 수행하였다. 특히, 카메라-라이다 간의 캘리브레이션은 두 센서 간의 상대적 회전 및 평행 이동 정보가 포함된 두 센서 사이의 외부 파라미터[R|t]를 구하는 것이다. 이를 위해 ArUco 마커를 이용하여 3차원 공간에서의 점 대응을 이용한 카메라-라이다 캘리브레이션을 수행하였다 (Dhall et al., 2017). 그리고 카메라 이미지 내의 각 픽셀에 대응되는 라이다 점군데이터에 카메라의 RGB 색상 정보 값을 대입함으로 카메라-라이다 투영을 수행하였다.

2.2 저조도 이미지 개선을 위한 이미지 전처리 기법

카메라의 특성상 외부 조도 변화에 따라 이미지 내 색상 정보는 민감하게 변하며, 저조도 환경에서 획득한 이미지에서 추출한 색상 정보를 라이다의 점군데이터에 직접적으로 투영시키면 객체 본연의 색상 정보를 반영하는데 한계가 있다 (Zhang et al., 2022). 무인수상선에 탑재된 카메라를 이용하여 획득한 저조도 환경의 이미지 밝기를 자동으로 보정하기 위해 감마 보정(gamma correction) 및 히스토그램 스트레칭(histogram stretching) 기법을 순차적으로 적용하였다. 감마 보정 기법은 입력된 이미지에 비선형적 변환 함수를 적용하여 출력 이미지의 대비를 개선하는 기법으로 다음 식 (1)을 이용하여 이미지를 변환할 수 있다 (Kusuma and Santoso, 2022).

| (1) |

위의 식에서 I는 입력 이미지를 나타내며 I'는 감마 보정이 적용된 출력 이미지를 나타낸다. 보정되어 출력된 이미지는 명암대비가 낮아지고 히스토그램이 특정 구간으로 밀집되어 전반적으로 흐려지는 효과가 이미지에 나타나는 단점이 있다. 흐려진 이미지의 색상 정보를 활용하여 라이다 융합을 통해 정합한다면 정확한 색상 표현이 어려워지기 때문에 명암 대비를 높여 흐려진 이미지의 색상 정보를 선명하게 보정하는 전처리 기법 적용이 필요하다.

히스토그램 스트레칭 기법을 추가로 적용하여 이미지의 색상 정보를 보정하였다. 히스토그램 스트레칭은 히스토그램의 최솟값(minimum)과 최댓값(maximum)을 이용하여 히스토그램을 전 구간으로 분포시키는 기법으로 명암 대비가 높아지고 선명한 이미지로 보정된다 (Kaur and Sohi, 2017). 히스토그램 스트레칭은 이미지의 전체 픽셀값 범위에서 이미지의 최솟값과 최댓값을 결정하고 최솟값을 0으로, 최댓값을 255(0~1로 정규화하면 1)로 매핑하여 이미지의 특정 구간에 밀집된 히스토그램을 전 구간 범위로 확장하는 것으로 식 (2)와 같은 식을 통해 정의할 수 있다.

| (2) |

여기서, I'는 감마 보정이 적용된 이미지이고, I''는 히스토그램 스트레칭이 적용된 출력 이미지이다. 그리고 Gmin은 픽셀값 중 최솟값이며 Gmax는 최댓값에 해당한다.

2.3 3차원 점군데이터 처리 기법

고밀도의 3차원 공간 정보를 생성하기 위해 3차원 라이다 센서의 점군데이터가 주로 활용된다. 라이다의 점군데이터는 라이다에 내장된 레이저 빔(laser beam)이 360도 회전하며 주사되고, 객체 표면에서 반사되어 되돌아오는 레이저 빔의 물리적 속성을 고려하여 대상 객체와의 3차원적 상대적 거리 및 방위 정보를 포함하고 있다. 라이다가 고정된 상태에서는 연속적으로 입력된 점군데이터의 유효성을 확보할 수 있으나, 본 연구에서는 라이다가 자율운항하는 무인수상선에 탑재되므로 무인수상선의 자세 변화에 따라 유효한 점군데이터를 획득하는 과정이 필요하다. 이를 위해 무인수상선에 탑재된 IMU 정보를 이용하여 무인수상선의 자세가 안정화된 상태에서 점군데이터를 획득하는 과정을 전처리 과정 초기 단계에 적용하였다(Fig. 1). 또한, 해상 수면의 파도나 물결, 무인수상선의 선미에서 발생하는 후류 항적 등에 의해서도 레이저 빔이 난반사되어 점군데이터에 잡음이 포함되기도 한다. 이러한 잡음들은 연속적으로 획득한 점군데이터 간의 매핑 과정에서 정밀도의 오차를 유발하므로 데이터 전처리 과정에서 최소화하기 위한 필터링 기법들이 반드시 적용되어야 한다.

라이다로부터 일정 주기적으로 획득한 점군데이터의 잡음을 최소화하기 위해 사용된 필터링 기법은 크게 두 가지 기법을 순차적으로 적용하였다(Fig. 1). 점군데이터 내에 포함된 무의미한(invalid) 데이터를 제외하는 pass through 필터를 적용하여 개발한 무인수상선의 선체 크기와 센서의 탑재 높이를 고려하여 일정 반경 내의 점군데이터를 제외토록 하였다. 그리고 방대한 점군데이터를 제한된 프로세스의 리소스 영역 내에서 데이터의 효율적 처리를 위해 voxel grid와 downsampling을 적용하여 특정 영역 내에 위치한 밀집화된 점군데이터를 제외하였다. 순차적으로 두 가지의 필터링 기법을 통해 산출된 점군데이터는 점군데이터 간의 매핑 프레임워크에서 입력 점군데이터로 정의하여 이전 시점까지 누적된 점군데이터와 매핑하는 입력 데이터로 활용된다.

전처리 된 점군데이터 간의 매핑을 위해 G-ICP 기법을 적용하고 정량적으로 지표화된 점군데이터 간의 매핑 적합도를 기준으로 매핑 여부를 판단한다. 그리고 선별된 점군데이터를 G-ICP 기법으로 매핑한 결과에 보정된 이미지의 색상 정보를 매칭시켜 3차원 공간 정보를 생성하였다. point-to-point 기반의 ICP는 두 점군데이터 간의 유클리드 거리를 최소화하여 매핑한다. 하지만 두 점군데이터가 서로 다른 관점에서 매핑되는 상황에서는 점군데이터 간의 매핑 정확도가 낮아지기도 한다. 이를 보완하기 위해 두 점군데이터의 표면 법선 정보를 동시에 고려하여 매핑하는 point-to-plane 기반의 ICP 매핑 기법을 응용하여 매핑 과정 내 두 점군데이터의 거리의 최소화 단계에 확률모델(probabilistic model)을 추가하고 각 점에 대해 공분산 행렬을 적용하여 오차를 최소화하는 G-ICP를 적용하였다.

매핑을 위해 사용되는 두 점군데이터를 와 로 정의할 때, point-to-point 기반의 ICP의 변환 T는 식 (3)으로 나타낼 수 있다. 여기서 mi는 두 점군데이터 간의 매칭된 대응을 의미하며 이는 현재 변환 T에 따라 가장 근접한 점군데이터를 찾아 계산한다. 그리고 point-to-plane 기반의 ICP의 변환 T는 식 (3)을 식 (4)로 바꾸어 구현할 수 있다. ηi는 mi의 표면 법선 벡터를 의미한다.

| (3) |

| (4) |

G-ICP는 식 (4)에 확률모델을 추가하여 표현된다. 확률모델로 정의한 와 의 분포에 따라 A와 B를 생성하는 점군데이터의 집합 와 가 존재한다고 가정한다. 여기서 와 는 평균을 의미하고, 와 는 주변 점군데이터의 분포를 사용하여 계산되는 공분산 행렬을 의미한다. 이때, 두 점군데이터 간의 정확한 대응 관계와 올바른 변환 T*를 알 수 있다면, 와 의 관계는 식 (5)와 같이 나타낼 수 있다.

| (5) |

연속된 점군데이터 간의 회전 변환 T에 대한 거리 오차는 로 정의할 수 있다. 여기서, di는 대응 관계가 이루어진 두 점군데이터 사이의 유클리디언 벡터로 정의하고, ai와 bi는 독립적인 가우시안 확률분포를 따른다고 가정하면 식 (5)를 통해 를 식 (6)과 같이 유도할 수 있다.

| (6) |

마지막으로 Maximum Likelihood Estimation(MLE)을 사용하여 식 (7)의 T를 반복하여 계산하면 최종적으로 식 (8)과 같이 최적화할 수 있다 (Kim et al., 2019; segal et al., 2009; Servos and Waslander, 2017).

| (7) |

| (8) |

이와 같은 과정을 수행하여 구한 변환 T에 따라 거리를 최소화하여 두 점군데이터의 최근접 점을 찾아 두 점군데이터 간의 최적의 변환을 찾는 것에 중점을 둔다. 두 점군데이터의 매칭 정확도를 나타내는 score는 식 (9)와 같이 나타낼 수 있다, 이는 각 점군데이터 별 거리 제곱의 평균으로 표현되며, score의 값이 낮을수록 매칭의 정확도가 높다. 여기서 N은 점의 개수, ai와 bi는 두 점군데이터이다.

| (9) |

3. 무인수상선 시스템

3.1 무인수상선 플랫폼

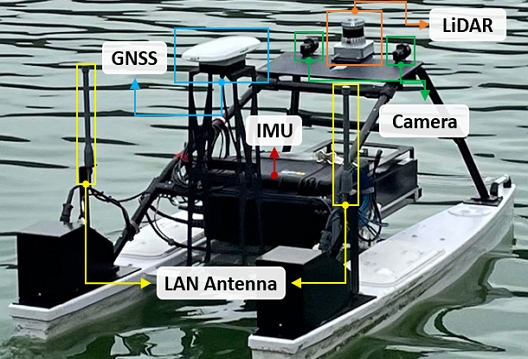

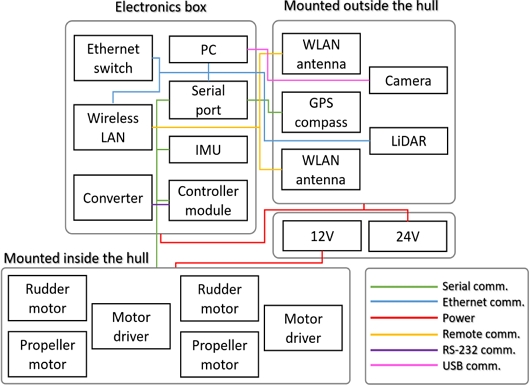

본 연구에서 제안된 매핑 프레임워크의 성능을 검증하기 위해 개발한 무인수상선은 Fig. 2와 같이 선체의 길이가 2m급인 쌍동선 타입의 쌍축, 쌍타형으로 설계되었다. 그리고 Fig. 3은 무인수상선의 시스템의 구성도를 나타내며, 항법 및 제어 시스템, 추진 시스템, 통신 시스템, 인식 시스템 등으로 구성되어 있다. 항법 및 제어 시스템에서는 탑재된 GNSS-compass와 IMU 센서를 이용하여 무인수상선의 위치와 자세 정보를 계측하고, 사전에 정의된 경유점을 자율적으로 추종하는 유도 및 제어 기법이 구현되어 있다. 추진 시스템은 쌍축, 쌍타형으로 추진기와 방향타의 제어 명령에 따라 속도 및 각도를 제어하도록 구현되었다. 그리고 통신 시스템은 원격으로 무인수상선의 기본적 상태 모니터링을 가능하도록 2.4GHz 대역의 무선 LAN 모듈과 비상 운항 시의 긴급 원격 제어를 위한 RF 통신 모듈을 포함하고 있다. 인식 시스템은 주로 3차원 공간 정보를 생성하는 용도로, 카메라(blackfly S USB3)와 라이다(ouster OS1-64)로 구성하였다. 탑재 라이다는 최대 120m 범위의 거리 측정이 가능하고, 수직으로 45도 범위의 스캔이 가능하다. 시스템의 운영체제는 각 모듈 간의 연계성과 확장성을 고려한 로봇운영체제(ROS, Robot Operating System)를 기반으로 구성하였다.

3.2 3차원 공간 정보 계측을 위한 자율운항

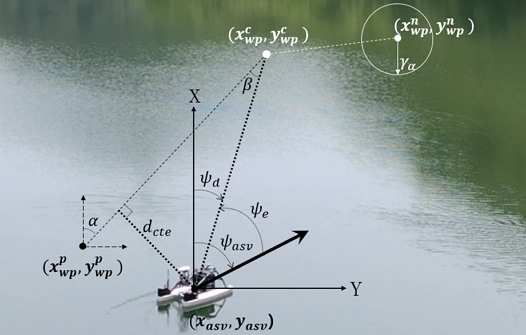

무인수상선을 운용하는 영역 내의 디지털 트윈 공간을 자동으로 생성하기 위해 무인수상선이 자율적으로 운항하며 탑재된 카메라 및 라이다를 이용하여 데이터를 확보하도록 자율운항 시스템을 구축하고 경유점 추종을 위한 유도 및 제어 기법을 구현하였다. 운용하는 영역 내에서의 운항 범위와 인식 시스템의 운용 한계를 고려하여 경유점을 선정하였다. 선정한 경유점을 순차적으로 추종하기 위해 시선각(LOS, Line Of Sight) 유도 기법을 기반으로 식 (10)과 식 (11)을 통하여 현시점에서의 경유점을 추종하기 위한 무인수상선의 목표 침로를 산출하였다 (Park et al., 2023; Heo et al., 2023). 각 식에서 사용된 주요 인자와 좌표계는 Fig. 4와 같이 정의하였다.

| (10) |

| (11) |

여기에서, xasv, yasv 및 , 는 무인수상선과 목표 경유점의 위도와 경도의 단위를 Universal Transverse Mercator (UTM) 좌표계로 변환한 2차원 평면에서의 위치를 의미하며, 단위는 미터(m)로 나타낸다. 그리고 ψasv는 현시점에서 무인수상선에 대한 선수각 정보를 나타낸다. 좌표계 x축을 기준으로 현재 목표 경유점의 각도는 ψd로 나타내고, ψe는 무인수상선의 현재 선수 각을 기준으로 목표 경유점까지의 각도 오차를 나타내며, 이 오차는 시선각 오차로 정의하였다.

경유점 간의 직선거리를 최대한 유지하며 3차원 공간 정보를 확보하기 위해서 수선 거리(cross track) 유도 기법을 동시 적용하였다. 이전의 경유점 , 에서 현재 목표 경유점 , 으로 이동할 때, 두 경유점 간의 직선과 현재 무인수상선 위치와의 수선 거리를 오차인 수선 거리 오차(CTE, Cross Track Error)로 정의하고, 다음 식 (12)~(14)를 통하여 산출하였다.

| (12) |

| (13) |

| (14) |

산출된 시선각 오차 및 수선 거리 오차를 최소화하는 침로 제어 명령을 생성하기 위해 PD 제어기를 다음 식 (15)와 같이 구현하였다.

| (15) |

여기에서 와 , 와 는 각각 시선각 오차 및 수선 거리 오차에 대한 비례와 미분제어 게인이며, Tcte는 거리 단위에서 각도 단위로 변환하는 상수를 나타낸다.

4. 내수면 실험 결과

4.1 내수면 실험 개요

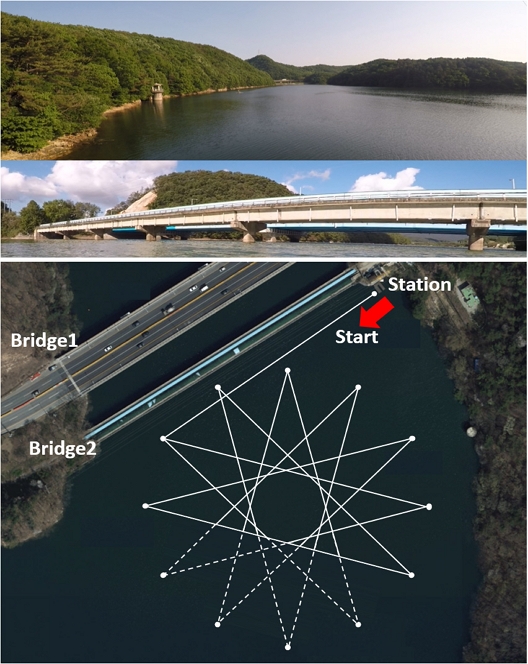

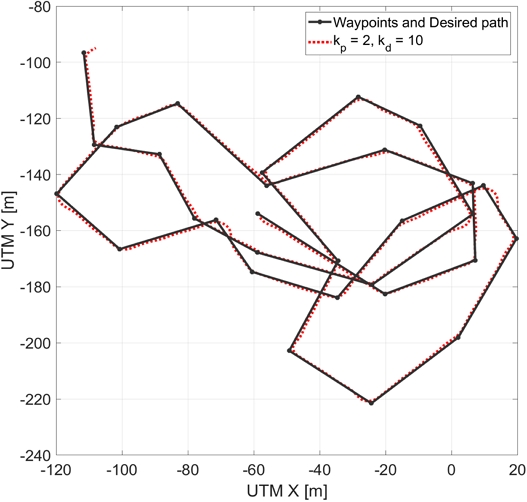

개발한 무인수상선을 이용하여 설계한 매핑 프레임워크를 통해 디지털 트윈 공간에서 활용할 3차원 공간 정보를 생성하는 실험은 대전 방동저수지 수역에서 수행하였다. Fig. 5와 같이 실험 공간에서는 인공 구조물인 교량 2개가 한쪽 면에 접해있고 그 외에는 숲과 나무로 둘러싸여 있는 공간에서 무인수상선의 운용 가능한 범위 내에서 총 13개의 경유점을 설정하여 자율적으로 운항하며 인식 및 항법 센서의 데이터를 취득하는 실험을 수행하였다. Fig. 5에서 점선으로 표현된 경유점 간 직선 구간의 경우는 라이다의 탐지 범위를 벗어나 점군데이터가 없는 영역을 나타낸 것이며, 실선으로 표현된 구간의 데이터를 활용하여 3차원 공간 정보를 생성하였다.

4.2 경유점 추종 제어 시험 결과

본 연구에서 개발한 무인수상선의 자율운항에 관한 기본 성능을 검증하는 실험을 진행하였다. 선회 시험의 경우 무인수상선의 최대 선회경의 전술직경이 각 3.6L과 3.75L이었으며, 무인수상선의 선체 길이(L=2m)의 5배가 넘지 않은 것을 확인하였다. 지그재그 시험의 경우 좌현과 우현 각각 10°/10°의 1차 오버슈트 각(overshoot angle)과 2차 오버슈트 각의 차이가 15도를 초과하지 않았고, 20°/20°의 1차 오버슈트 각은 25도를 초과하지 않았다. 따라서 선회 시험 및 지그재그 시험을 통하여 IMO에서 제시하는 조종성 기준에 부합함을 확인하였다(Table 1).

자율운항을 위한 경유점 추종 제어 시험을 위해 각 경유점 도달 여부를 결정하는 허용반경(acceptance radius)은 무인수상선의 선체 길이의 3배인 6m로 설정하였다. 시험 결과(Fig. 6)에서의 검은색 실선은 연속된 경유점을 직선으로 연결한 최적 경로를 나타내며, 빨간색 점선은 구현된 유도 및 제어 기법에 따라 무인수상선이 운항한 궤적을 나타낸다. 목표 경유점에 도달하여 새로운 목표 경유점으로 운항하는 과정에서 궤적의 오차가 발생하는 것을 볼 수 있으나 기준 경로에 대한 수선 거리의 평균 제곱근 오차(RMSE)는 1.225m로 선체 길이를 고려하면 2m 이내의 오차 범위를 갖으므로 구현한 유도 및 제어 기법의 성능이 좋은 것을 확인하였다. 그리고 경유점 추종 제어 실험에서 PD 제어기의 게인을 찾기 위하여 가변하며 실험을 수행하여 적합한 제어 게인을 선정하였다.

4.3 전처리 기법의 적용 결과

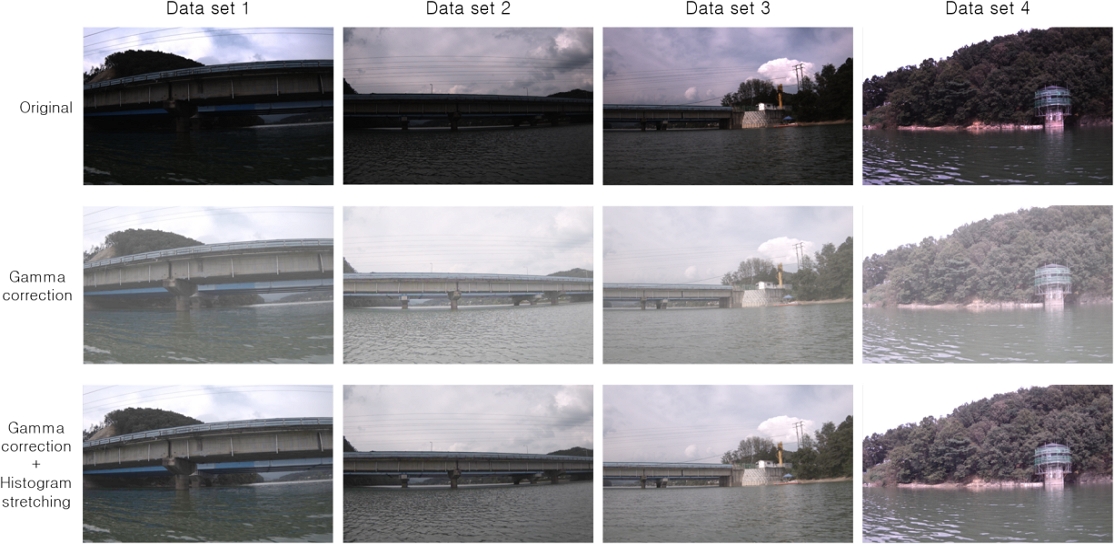

무인수상선이 자율운항 과정에서 교량에 근접하거나 빛을 마주 보고 운항하는 상황에서 카메라의 조도가 낮아지는 상황이 빈번하게 발생하였다. 또한, 카메라 렌즈의 밝기 설정 시에는 실외에서의 실험임을 고려하여 빛의 수면 반사 등과 같은 빛의 잡음을 최소화하기 위해 실제 밝기보다 다소 어둡게 설정하였다. Fig. 7에서 상단에 있는 이미지 데이터 세트를 보면, 조도가 낮은 이미지들이 계측된 것을 볼 수 있으며, 제안한 전처리 기법을 적용하여 색상 정보가 크게 개선됨을 확인할 수 있다.

Results of the image preprocessing: brightness enhancement for low-light images; from top to bottom original image, gamma corrected image, gamma corrected and histogram stretching image

감마 보정 기법에서는 식 (1)의 γ값 설정이 필요한데, 실험 환경에서 확보한 이미지들의 히스토그램 분석을 통한 통계적 데이터를 토대로 γ값을 0.3으로 적용하였다. 이를 통해서 Fig. 7과 같이 원본 이미지에 감마 보정 기법을 적용한 결과 상대적으로 어두운 부분이 밝아짐을 확인하였다. 전반적으로 밝아지는 부분은 개선되었으나, 명암대비가 낮아져 이미지에 안개가 낀 것과 같이 이미지가 전체적으로 흐리게 나타난 것을 확인하였다. 이를 개선하기 위해 히스토그램 스트레칭 기법을 적용하여 명암대비를 높인 이미지를 획득하였고, 그 결과 이미지를 Fig. 7의 하단에 표기하였다.

라이다의 점군데이터는 10Hz로 입력되고 무인수상선의 운항 속도는 1kn로 유지하면서 운항하므로 상대적으로 이동 거리가 매우 짧은 상황이다. 이러한 상황은 연속적으로 많은 점군데이터가 입력되어 전처리를 수행하는 연산 과정에서 큰 부하를 발생시킨다. 따라서, 짧은 이동 지점에서 계측된 점군데이터에는 많은 부분이 중복되고 잡음에 의한 공간 정보의 왜곡이 발생할 수 있으므로, 이를 최소화하기 위하여 무인수상선이 약 2.5m 간격으로 운항하며 점군데이터를 계측하도록 설정하였다. 그리고 입력되는 점군데이터의 잡음을 최소화하기 위해 무인수상선의 선체 크기와 라이다 센서의 탑재 위치 정보를 반영한 pass through 필터를 적용하였고, 연산 효율을 증대시키기 위하여 voxel grid downsampling 기법을 통해 0.5m 간격의 밀집된 점군데이터를 하나의 점군데이터로 표현하여 잡음을 최소화하였다.

4.4 3차원 공간 정보 생성 결과

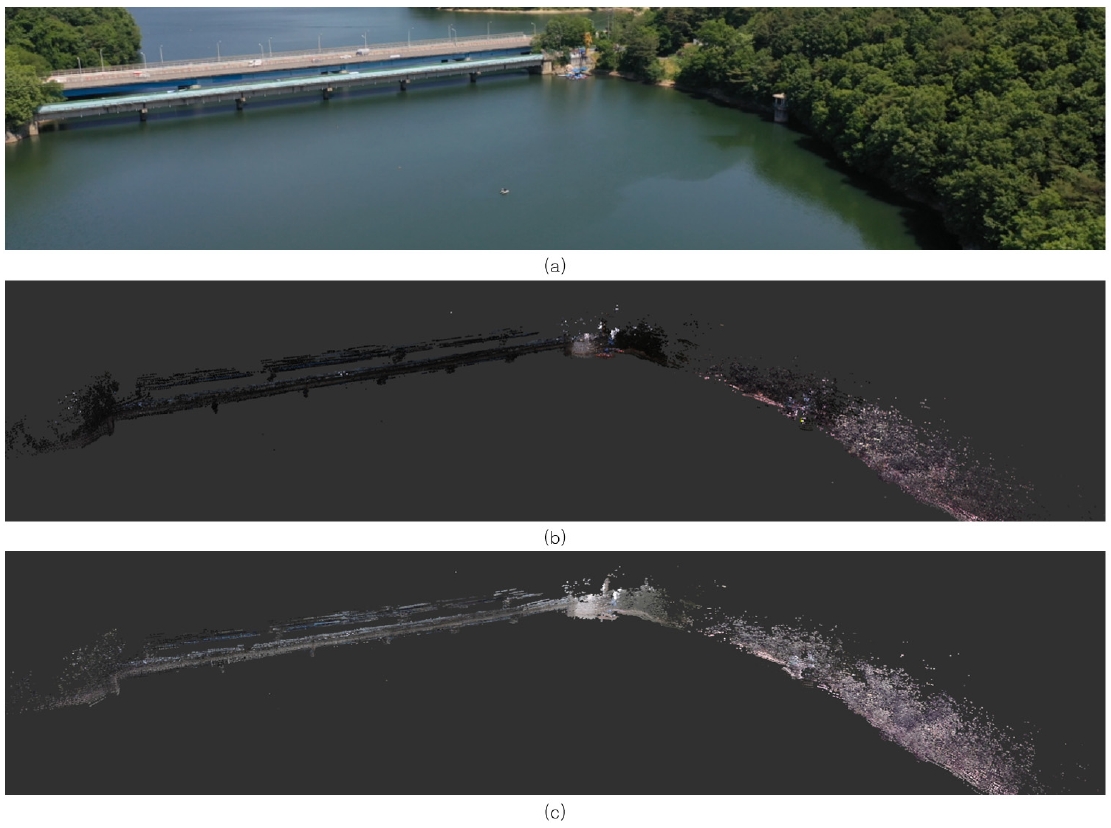

전처리 과정을 통한 카메라 및 라이다의 데이터를 매핑하여 디지털 트윈 공간에서의 활용이 가능한 3차원 공간 정보를 생성한 결과는 Fig. 8과 같다. Fig. 8(a)는 드론을 활용하여 촬영한 실험 영역의 촬영한 이미지이며, Fig. 8(b)는 라이다는 점군데이터의 전처리 기법이 적용되었으나 카메라의 이미지 전처리 기법이 적용되지 않아 상대적으로 저조도 색상 정보가 반영된 매핑 결과로 실제 촬영한 이미지와 상이한 점이 많이 있음을 볼 수 있다. Fig. 8(c)는 라이다의 점군데이터와 카메라의 이미지 전처리 기법이 적용되어 매핑 결과로, 보정된 색상 정보가 반영된 3차원 공간 정보가 Fig. 8(a)의 촬영 이미지 정보에 근접함을 확인할 수 있다. 그리고 라이다의 점군데이터가 전처리 과정 및 G-ICP 기법을 적용한 과정에서 소실되는 영역이 발생하였는데, 이는 무인수상선의 자세 급변에 따라서 잡음으로 분류되어 제외되는 현상으로 확인된다.

Results of 3D spatial reconstruction using camera and LiDAR mounted on the developed ASV: (a) test site image for the field test in inland water environment; (b) a 3D spatial reconstruction result using camera and LiDAR without the proposed approach; (c) a 3D spatial reconstruction result using camera and LiDAR with the proposed approach

5. 결 론

본 논문에서는 무인수상선에 탑재된 항법 센서 및 카메라와 라이다 센서를 이용하여 디지털 트윈 공간에서 활용할 수 있는 3차원 공간 정보를 생성하는 매핑 프레임워크를 제안하였다. 특히, 3차원 공간 정보에 색상 정보를 반영하는 과정에서 조도 변화에 강인한 이미지 전처리 기법을 새롭게 적용하여 색상 정보를 보정하는 방안을 제시하였고, 그 결과와 라이다의 점군데이터 간의 G-ICP 기법을 통해 연속된 정보를 누적하여 현실감 높은 3차원 공간 정보를 생성하였다. 또한, 수상 운용 환경에서 발생하는 각 센서들의 고유 잡음과 6자유도 운동에 의한 데이터 매핑 시의 왜곡을 최소화하기 위한 과정들이 매핑 프레임워크에 적용되었다. 그리고 카메라와 라이다를 탑재한 무인수상선을 개발하여, 내수면 환경에서 자율적으로 운항하며 주변 환경 정보를 획득한 카메라 및 라이다 데이터를 기반으로 3차원 공간 정보를 생성하는 매핑 프레임워크의 적용 가능성을 검증하였다. 추후, 제안한 매핑 프레임워크를 무인수상선의 항법 정보를 동시 보정하는 SLAM 프레임워크와 연계하여, 무인수상선을 대상으로 광역 범위를 운용하며, 고정밀의 3차원 공간 정보를 생성하는 연구를 진행할 계획이다.

Acknowledgments

본 논문은 선박해양플랜트연구소의 주요 사업인 ‘디지털트윈쉽 모델링/시뮬레이션 및 상태 인식/추론 핵심기술 개발(PES5210)’의 지원으로 수행되었습니다.

References

-

Campos, D.F., Matos, A., and Pinto, A.M., 2020. Multi-domain mapping for offshore asset inspection using an autonomous surface vehicle. In 2020 IEEE International Conference on Autonomous Robot Systems and Competitions (ICARSC) (pp. 221-226). IEEE.

[https://doi.org/10.1109/ICARSC49921.2020.9096097]

- Dhall, A., Chelani, K., Radhakrishnan, V. and Krishna, K. M., 2017. LiDAR-camera calibration using 3D-3D point correspondences. arXiv preprint arXiv:1705.09785, .

- Feixiang, Z.H.U. and Jiandao, L.I.U., 2019. Research on Marine Buoy Surface Reconstruction Algorithm Based on Point Cloud Data. In 2019 6th International Conference on Information Science and Control Engineering (ICISCE) (pp. 480-484). IEEE.

-

Heo, S.H., Kang, M.J., Choi, J.W., Yun, S.W. and Park, J.H, 2023. A Preliminary Study for Development of Digital Twin Ship Technology Using Autonomous Surface Vehicle. In 2023 20th International Conference on Ubiquitous Robots (UR) (pp. 255-260). IEEE.

[https://doi.org/10.1109/UR57808.2023.10202274]

-

Joung, J.H., An, K.H., Kang, J.W., Chung, M.J. and Yu, W.P., 2009. 3D environment reconstruction using modified color ICP algorithm by fusion of a camera and a 3D laser range finder. IEEE/RSJ International Conference on Intelligent Robots and Systems, pp.3082-3088.

[https://doi.org/10.1109/IROS.2009.5354500]

-

Jung, J.D., Park, J.H., Lee, Y.J., Yeu, T.K., Choi, J.W. and Han, J.B., 2023. Consistent mapping of marine structures with an autonomous surface vehicle using motion compensation and submap-based filtering. Ocean Engineering, 290, 116418.

[https://doi.org/10.1016/j.oceaneng.2023.116418]

-

Kaur, H. and Sohi, N., 2017. A study for applications of histogram in image enhancement. International Journal of Engineering and Science (IJES) 6(6), 59-63

[https://doi.org/10.9790/1813-0606015963]

-

Kim, H.G., Song, S.W. and Myung, H., 2019. GP-ICP: Ground plane ICP for mobile robots. IEEE Access, 7, 76599-76610.

[https://doi.org/10.1109/ACCESS.2019.2921676]

-

Kusuma, B.N. and Santoso, D.B., 2022. Improvement of the automatic gamma correction method in cloud image detection. Matrix: Journal Manajemen Teknologi dan Informatika, 12(3), 137-146.

[https://doi.org/10.31940/matrix.v12i3.137-146]

-

Leedekerken, J.C., Fallon, M.F. and Leonard, J.J., 2010. Mapping complex marine environments with autonomous surface craft. In Experimental Robotics: The 12th International Symposium on Experimental Robotics, pp.525-539.

[https://doi.org/10.1007/978-3-642-28572-1_36]

-

Madusanka, N.S., Fan, Y., Yang, S. and Xiang, X., 2023. Digital twin in the maritime domain: A review and emerging trends. Journal of Marine Science and Engineering, 11(5), 1021.

[https://doi.org/10.3390/jmse11051021]

-

Park, H.S., Son, N.S. and Pyo. C.S., 2023. A Study on Playback of Ship Collision Accident Using Free Running Model Test. Journal of the Society of Naval Architects of Korea, 60(6),450-459.

[https://doi.org/10.3744/SNAK.2023.60.6.450]

-

Sattler, F., Barnes, S., Carrillo Perez, B.J., Stebner, K., Stephan, M. and Lux, G., 2022. Real-time embedded reconstruction of dynamic objects for a 3D maritime situational awareness picture. In European Workshop on Maritime Systems Resilience and Security.

[https://doi.org/10.1007/s00371-023-02802-4]

-

Segal, A., Haehnel, D. and Thrun, S., 2009. Generalized-icp. In Robotics: science and systems, 2(4), pp.435

[https://doi.org/10.15607/RSS.2009.V.021]

-

Servos, J. and Waslander, S.L., 2017. Multi-Channel Generalized-ICP: A robust framework for multi-channel scan registration. Robotics and Autonomous systems, 87, 247-257.

[https://doi.org/10.1016/j.robot.2016.10.016]

-

Wang, P., 2021. Research on comparison of LiDAR and camera in autonomous driving. Journal of Physics: Conference Series, 2093(1), pp.012032.

[https://doi.org/10.1088/1742-6596/2093/1/012032]

-

Zhang, T., Liu, C., Li, J., Pang, M. and Wang, M., 2022. A new visual inertial simultaneous localization and mapping (SLAM) algorithm based on point and line features. Drones, 6(1), 23.

[https://doi.org/10.3390/drones6010023]

-

Zhao, X., Sun, P., Xu, Z., Min, H. and Yu, H., 2020. Fusion of 3D LIDAR and camera data for object detection in autonomous vehicle applications. IEEE Sensors Journal, 20(9), pp.4901-4913.

[https://doi.org/10.1109/JSEN.2020.2966034]