인공지능 기반 선체 균열 탐지 현장 적용성 연구

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

With the advent of autonomous ships, it is emerging as one of the very important issues not only to operate with a minimum crew or unmanned ships, but also to secure the safety of ships to prevent marine accidents. On-site inspection of the hull is mainly performed by the inspector's visual inspection, and video information is recorded using a small camera if necessary. However, due to the shortage of inspection personnel, time and space constraints, and the pandemic situation, the necessity of introducing an automated inspection system using artificial intelligence and remote inspection is becoming more important. Furthermore, research on hardware and software that enables the automated inspection system to operate normally even under the harsh environmental conditions of a ship is absolutely necessary. For automated inspection systems, it is important to review artificial intelligence technologies and equipment that can perform a variety of hull failure detection and classification. To address this, it is important to classify the hull failure. Based on various guidelines and expert opinions, we divided them into 6 types(Crack, Corrosion, Pitting, Deformation, Indent, Others). It was decided to apply object detection technology to cracks of hull failure. After that, YOLOv5 was decided as an artificial intelligence model suitable for survey and a common hull crack dataset was trained. Based on the performance results, it aims to present the possibility of applying artificial intelligence in the field by determining and testing the equipment required for survey.

Keywords:

Hull failure, Crack, Artificial intelligence, Object detection키워드:

선체 손상, 균열, 인공지능, 객체 탐지1. 서 론

선박의 디지털화, 지능화 기술은 자율운항선박의 핵심 기술로 선박 설계, 건조, 운항, 관리와 관련한 빅데이터 기반 인공지능 기술로 실현이 가능해진다. 특히, 자율운항선박의 등장은 최소 선원 또는 무인 선박으로 운항하는 상황뿐만 아니라 해양 사고 방지를 위한 선박 자체의 안전성 확보가 매우 중요한 사안 중 하나로 대두되고 있다.

현장에서 선체 손상 탐지와 진단은 검사원의 육안 검사가 주를 이루고 있으며, 필요에 따라 소형 방수·방진 카메라를 활용해 영상 정보를 기록하고 있다. 그러나, 검사 인력의 부족, 시간·공간적 제약, 팬데믹 상황, 현장 접근성 등 다양한 제약 상황으로 인해 원격 검사 및 인공지능을 활용한 검사 자동화 시스템 도입의 필요성이 중요시되고 있다. 따라서 선박의 무인화가 최종적으로 구현되기 위해서는 운항 이외에 선박의 안전 관리에도 무인화를 위한 인공지능 기술 적용은 절대적으로 필요하다.

이는 협소·고소 공간, 통신, 습도, 먼지, 염분, 조도 등 열악한 선박 환경에서 인공지능 기술을 활용한 선체 손상 탐지 기술 적용은 소프트웨어 관점뿐만 아니라 하드웨어 관점에서도 현장의 적용성 연구가 반드시 수행되어야 한다.

Ortiz et al. (2016)는 3개 층으로 구성된 인공신경망을 기반으로 도장 탈락으로 인한 부식과 부식이 아닌 부분을 분류하는 모델을 구성하여 드론에 부착된 센서 등을 활용해 선박의 현장 검사 적용성이 연구되었다. Xie et al. (2021)의 경우 선박의 균열을 RetinaNet과 제안하는 추적 알고리즘을 활용해 탐지했다. Kim and Cho (2018)는 Convolutional Neural Network (CNN)인 AlexNet 모델 기반으로 콘크리트 표면에서의 균열을 드론으로 탐지하고자 했고 추론 속도는 3 FPS 정도로 영상 기반의 콘크리트 균열 탐지 가능성을 확인했다. 마찬가지로 Liu et al. (2019)는 segmentation 목적인 U-Net을 활용해 콘크리트의 균열을 탐지했다. 손상 탐지 종류로는 균열이 대부분이었으며, CNN 기반의 object detection 및 segmentation 등이 사용되었다. 하지만 실제 현장에서 수행되는 지침과 요구 장비 분석 그리고 인공지능의 현장 적용성 연구는 미비했다.

따라서 이 연구에서는 실시간 영상 정보를 기반으로 선체 손상을 탐지하고 자동으로 보고할 수 있는 선체 손상 탐지 시스템 개발을 최종 목표로 다양한 선체 손상 중 구조적 중요도가 매우 높은 균열을 대상으로 인공지능 기반 탐지 기술의 현장 적용성을 연구한다. 수집된 데이터 특성과 검사 환경을 고려하여 균열 탐지 인공지능 모델을 선정하고 학습하였으며, 학습된 가중치를 기반으로 다양한 검사 장비를 통해 현장 테스트를 수행했다.

2. 선체 손상 데이터 확보

2.1 선체 손상 분류

선체 손상, 즉 구조적 손상 및 강도 저하는 다양한 원인으로 발생할 수 있다. 특히 설계 오류, 용접 결함, 피로 등이 대표적이다. 따라서 다양한 선체 손상을 한국선급, Korean Register (KR)의 기준으로 분류하여 적합한 인공지능 학습 특성을 가진 손상을 찾고자 했다.

국제선급협회, International Association of Classification Society (IACS), Double Hull Oil Tankers - Guidelines for Surveys, Assessment and Repair of Hull Structures (IACS, 2019)에서는 손상은 일반적으로 재료의 쇠모(material wastage) 또는 부식(corrosion)과 균열/파단(fractures), 변형(deformation)을 말하며 여러 선종과 손상 원인, 양상 그리고 재질 등에 따른 손상에 대해 상세히 기술하고 있다. 또한 Hull Classification Surveys (IACS, 2020)에선 선체 검사는 4가지(substantial corrosion, significant deformation, fractures, damages or other structural deterioration)를 발견하여 구조적 무결성이 유효함을 확인하는 것이 목적으로 기술되어 있어 대략적인 손상의 종류를 파악할 수 있다.

KR에서는 IACS 및 ISSC (2009)에서 제시된 손상 종류와 전문가 의견을 근거로 데이터셋 구축에 사용될 선체 손상 class로 Fig. 1과 같이 균열, 부식, 변형, 그 외(others) 4종과 부식과 변형의 세부 손상인 점식(pitting) 그리고 찍힘(indent) 2종, 총 6종으로 분류했다.

2.2 선체 손상 데이터셋 구축

선체 손상 데이터 구축을 위해 KR 내부에서 약 5,500장의 사진을 수집했다. 사진 데이터 해상도는 Video Graphics Array (VGA) 640x480 해상도 이하부터 Ultra High Definition (UHD) 3840x2160 해상도 이상까지 다양할 뿐만 아니라 ISO와 초점 거리, 카메라 모델 등이 상이했다. 대체적으로는 광량이 적은 환경인 선체 내부에서 촬영되어 어둡고, 협소한 공간과 촬영 자세의 불안정으로 인한 손상부 초점 흐림과 흔들림 등이 존재했다. 이 밖에도 높은 곳의 위치한 손상을 촬영해 대상이 작게 보이는 경우, 먼지로 인한 초점이 맞지 않는 경우 등이 발견되었다.

불량 사진 데이터를 1차 검수하고, 전문가를 통해 2차 검수를 거쳐 6종 손상에 속하는 사진을 필터링했다. 그 결과 균열과 부식 데이터가 전체 손상 데이터의 80 % 이상을 차지하는 것을 확인할 수 있었다. 각 class의 세부 개수는 Table 1에 나타냈다.

균열의 경우 비교적 형태가 뚜렷하고 주변부와의 차이가 존재했다. 손상의 범위 또한 한정적으로 진행된 경우가 많았다. 반면에 부식과 점식은 형태와 범위를 특정하기 힘들었다. 변형과 찍힘은 형태를 특정할 수 있지만, 주변부와의 특징이 비슷한 양상을 보였다. 이러한 손상 특징으로 균열의 boundary-box labeling과 데이터 개수를 고려했을 때 인공지능 객체 탐지 적용에 적합한 데이터로 판단했다. 따라서 이 연구에서는 6가지 손상 중 균열에 대하여 인공지능 학습을 수행하고 균열 객체 탐지 현장 적용성을 검토하였다.

3. 인공지능 학습

일반적으로 인공지능 학습 과정은 문제정의로 시작된다. 이 연구에서는 선체 검사 현장에 실질적인 도움이 되는 방법을 제공하는 것이 목적으로서 원격 검사 또는 협소, 고소 공간과 같은 물리적으로 닿기 힘든 곳 등에서 부가적 장비를 통해 얻어낸 영상 데이터 내에 손상의 위치를 찾아내는 것이 중요하다. 따라서 영상 내 다양한 구조물과 주변 환경들 사이에 존재하는 균열에 해당하는 객체를 찾아내는 ‘분류’ 문제로 정의 할 수 있다.

3.1 모델 선정

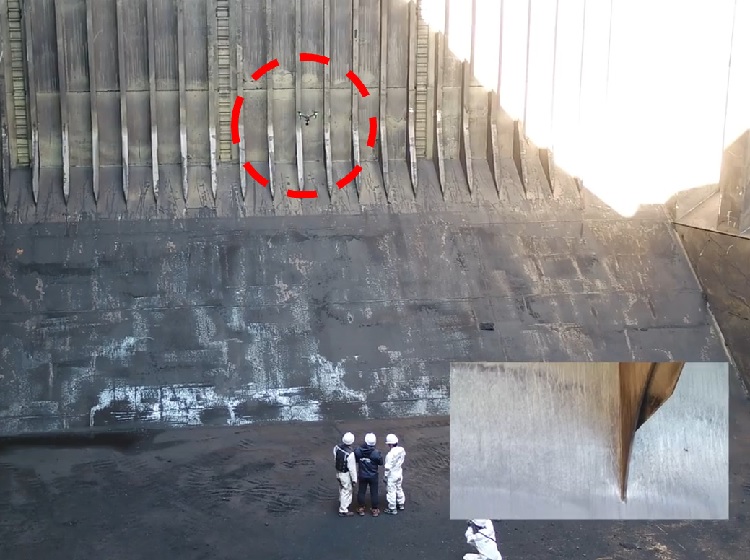

인공지능 모델은 일반적인 검사 환경에서 기록되는 균열 데이터 포맷인 사진을 기준으로 균열 탐지 성능이 우수해야 한다. 또한 Poggi et al. (2020)의 연구에서와 같이 원격 검사 활용 가능성을 고려한다면, Fig. 2처럼 검사원의 직접적, 물리적 접근 없이 검사할 수 있는 기술과 장비를 이용하여 문서를 포함한 정지, 실시간, 녹화의 세 가지 형식의 영상 시각 자료를 이용할 수 있어야 하며 (KR, 2022a), 연차 검사 시 실시간 영상을 통한 검사 방법이 수행 (KR, 2022b) 되어야 하므로 스트리밍 데이터의 인공지능 추론 속도 또한 고려해야 한다. 이에 따라 인공지능 모델은 수집된 사진과 동영상 데이터 및 지침을 만족하는 실시간 영상 데이터를 활용한 정확도와 추론 성능을 가져야 한다.

CNN single stage 기반의 객체 검출 모델은 높은 정확도와 빠른 속도로 추론할 수 있는 구조로서 대표적인 모델로 Single Shot Detection (SSD)와 You Only Look Once (YOLO) 그리고 RetinaNet등이 존재한다. 특히 YOLO는 사진을 격자 구조로 분할, 객체를 탐지하는 모델로 빠른 추론 속도와 높은 정확성 등으로 알려져 있다. 대표적인 연구로는 YOLOv4 (Bochkovskiy et al., 2020)가 있고, 영향을 받아 YOLOv5 개발되었으며, YOLOR (Wang et al., 2021) 등으로 발전해왔다. 이러한 연구 결과 바탕으로 실시간 영상 데이터를 충분히 처리할 수 있는 성능을 가진 모델 중 학습 편의성, 참고 자료 및 개발 안정성 등을 고려하여 YOLOv5를 균열 탐지 모델로 선정했다.

3.2 학습 데이터셋 구축

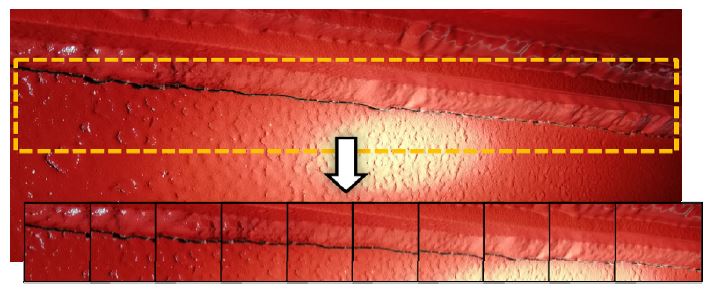

선체 균열 사진 정보를 살펴보면 촬영 환경과 장비가 다양하며 이에 따라 해상도, 배경 대비 손상부 크기 또한 상이함을 알 수 있다. YOLO는 입력 데이터를 일정한 grid로 나누게 되고 특정 gird cell 안에 여러 개의 bounding box로부터 confidence score를 계산하여 객체를 검출하는 방식으로 효과적인 균열 탐지를 위해 적절한 데이터셋 구축이 필요하다. 우선 데이터를 YOLOv5에서 권장하는 해상도인 640 픽셀로 통일했다. 특히 Fig. 3처럼 고해상도의 광범위한 손상이 나타난 사진의 경우 부분적으로 겹쳐 기준 해상도로 잘라내었다(overlap cut). 이는 데이터의 배경 대비 균열 비율을 높여 객체 형태와 위치를 노출 시킴과 동시에 물리적으로 데이터를 증가시키는 전처리로 볼 수 있다. 해당 과정을 거쳐 전체 데이터 개수를 기존의 663개에서 1,360개로 약 2배가량 증가시킬 수 있었다. 최종 데이터셋 사양은 Table 2와 같다.

3.3 학습 조건

학습은 On-premise 리눅스 서버와 프로세스 격리를 통한 컨테이너인 Docker 환경에서 수행하여 구성 라이브러리 버전 충돌과 같은 외부 변수로 인한 영향을 최소화하고자 했다. YOLOv5는 깊이와 층으로 계산된 파라미터 값별로 5종, x(xlarge) l(large), m(medium), s(small), n(nano), 모델로 나눠짐으로 이를 변수로 각 모델을 학습했다. 최적화 함수는 기본적으로 확률적 경사 하강법(stochastic gradient descent, SGD)과 Adam(adaptive moment)이 제공된다. 확률적 경사 하강법은 식 (1)과 같으며 가중치 θt+1는 학습률 η와 기울기 ⊽θJ(θ)로 인해 갱신된다.

식 (2)에 나타낸 Adam은 RMSProp 최적화 함수에 모멘텀을 추가 적용한 것으로 모멘텀이 사용하는 속도 벡터 mt와 적응적 학습률을 구하기 위해 그레디언트 누적 벡터 vt 를 계산한다.

이 연구에서는 확률적 경사 하강법 SGD를 사용했으며, Adam 최적화 함수는 학습 변수에서 제외하여 모델 규모에 따른 균열 탐지 적합성을 파악하고자 했다.

| (1) |

| (2) |

3.4 학습 결과

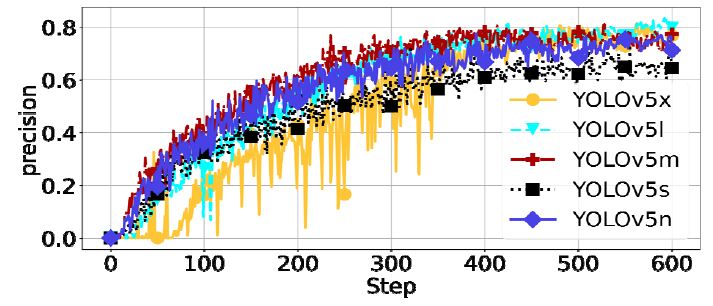

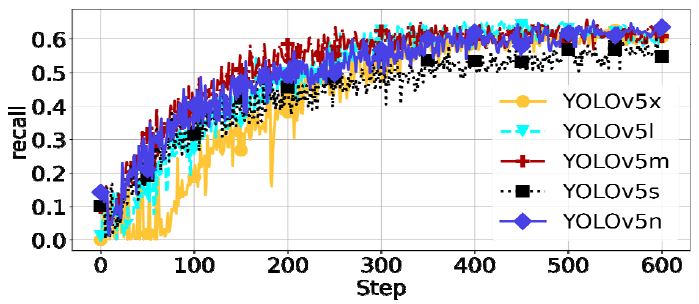

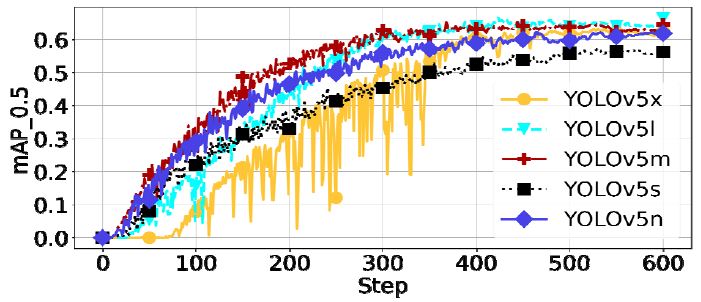

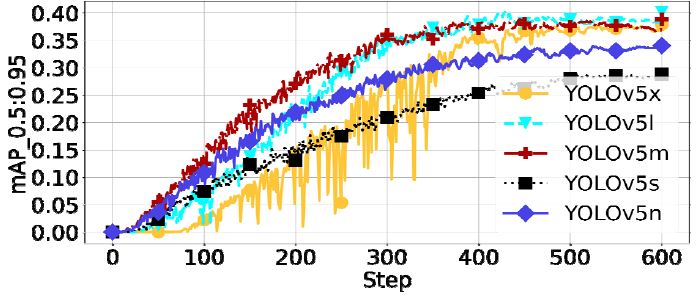

학습 시간 효율과 과적합 경향을 확인하기 위해 가장 작은 n 모델에서 300~1200 epochs까지 300 epochs 단위로 테스트 학습을 진행한 결과 600 epochs 이내로 주요 측정치가 수렴하고 있음을 확인할 수 있었다. 이후 본 학습에서는 이를 반영하여 600 epochs까지 진행됐고 평균 학습 시간은 1시간 14분이 소요됐다. Table 5와 Fig. 4~7에서 l 모델이 mAP 성능이 가장 높음을 알 수 있으며, Fig. 8에서 검증 데이터의 균열 탐지 결과에서 알 수 있듯이 사진 내의 모든 균열을 찾아내고 있으며 데이터가 너무 어두운 경우, 손상부로 판단하기 애매한 경우 등을 제외하면 대체로 균열을 잘 탐지하고 있음을 확인할 수 있다.

전체적인 학습은 적은 데이터 수와 단일 class 조건 그리고 최적화 함수의 노이즈로 인한 불안정성 등을 고려함에도 상대적으로 안정적인 측정치를 보였다. x 모델의 경우 모든 측정치가 고르게 진행하지 못함을 볼 수 있는데, 이는 타 모델 대비 높은 파라미터 값이 학습 경향에 영향을 준 것으로 생각된다. l 모델은 n 모델 대비 mAP 성능은 약 1.18배 높지만, CPU 추론 성능은 약 6배가량 낮았다. 이는 단순히 생각했을 때 실시간 영상 사양인 30 FPS를 기준, 1장에 필요한 추론 속도는 약 33.3 ms가 요구되므로 l 모델은 CPU 추론 시 원활한 속도를 보장하지 못하는 것으로 판단된다. 검사 환경에서 GPU를 활용한 추론이 보장받을 수 있다면, l 모델이 효과적이나 실시간 영상을 활용한 원격 선체 손상 검사에서 인공지능 적용 시 장비 가용성과 추론 속도를 고려했을 때 n 모델이 효율적임을 알 수 있다. 그러나 전체 모델은 현장 환경 조건에 따라 유연하게 결정될 수 있으며, 실제 검사 시 다양한 상황을 고려한 유기적인 판단이 필요함에 따라 적절한 인공지능 운영 프로세스 적용이 필요함을 알 수 있다.

모델 성능 평가에 사용된 평가 지표는 Table 6과 같다.

4. 현장 적용성 검토

4.1 장비 선정 및 테스트 시나리오

이 연구에서는 현장 적용성 검토(향후 활용 고려)에 사용될 검사 장비로 선박 내부의 먼지, 습기, 충돌 요소 등의 환경을 견딜 수 있는 범용적인 장비 중 휴대성과 조작성이 편리한 장비 위주로 2가지 방법을 선정하였으며, 무인 비행 장비는 통신과 검사 구역 등 작업 반경의 제약이 큰 이유로 제외했다. 특히, 원격 검사에 활용될 수 있도록 현장과 사무실과의 쌍방향 통신이 조건도 고려했다. 각 장비 사양을 Table 7에 나타냈다.

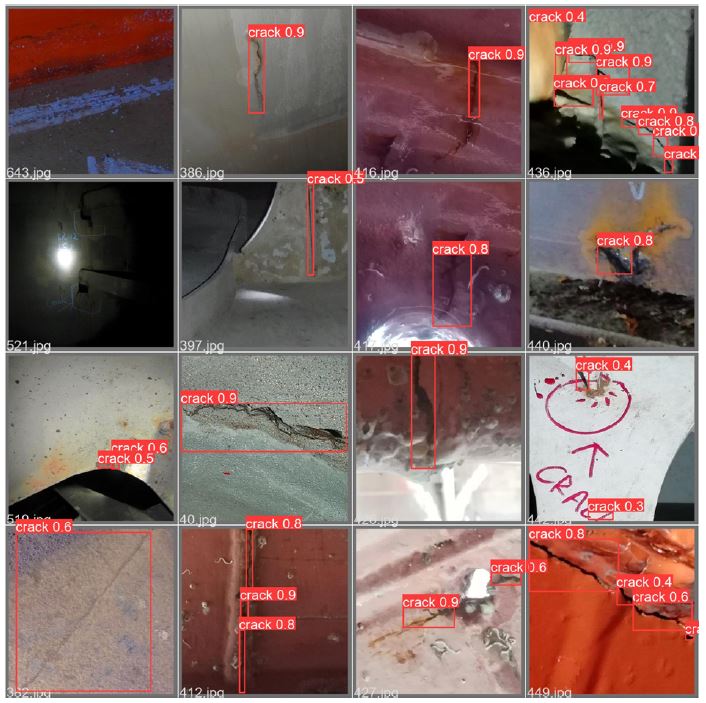

첫 번째로 GoPro는 시중에서 비교적 쉽게 접할 수 있는 촬영 장비로 사진과 동영상 모두에서 높은 품질을 얻어낼 수 있다. 검사 시나리오는 액션캠을 스마트폰 어플리케이션과 함께 운영하는 방법으로 원격 검사 시 실시간 영상을 통한 검사 상황을 가정하여 전송되는 영상에 학습된 인공지능 모델의 가중치를 적용, 추론하여 검사를 진행한다. 테스트 구성을 Fig. 9에 나타냈다.

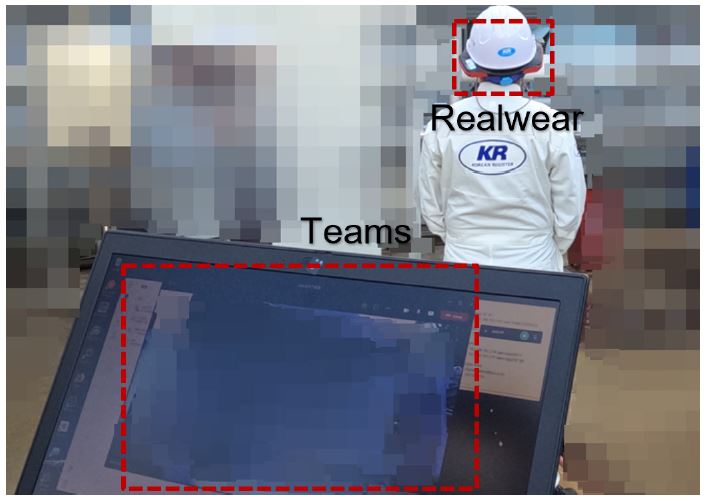

두 번째는 산업 현장 업무 보조용 웨어러블 장비인 Realwear를 사용하는 것으로 음성 인식 인터페이스를 통해 작동된다. 산업용으로 개발된 만큼 우수한 방수, 방진과 방폭 인증 사양을 보유하고 있다. 웨어러블 장비를 활용한 시나리오는 비즈니스 커뮤니케이션 플랫폼인 TEAMS를 활용해 실시간 영상 검사를 진행하지만, 인공지능 균열 탐지는 저장된 검사 영상을 통해 진행한다는 가정이다. 테스트 구성은 Fig. 10과 같다.

두 장비는 모두 자체적인 통신이 불가능한 점을 고려해 이를 보완하고자 휴대용 5G 라우터를 활용했다.

4.2 테스트 및 결과

GoPro는 스마트폰 내의 전용 어플리케이션에서 RTMP(Real Time Messaging Protocol)를 통해 실시간 영상 전송이 가능하다. 모바일 라우터의 같은 네트워크로 연결된 스마트폰 서버가 통신을 하기 위해 별도의 RTMP 서버를 필요로 하므로 오픈소스인 MonaServer를 활용했다. 실시간 영상은 360p, 720p, 1080p 해상도를 지원하므로 720p 이상의 해상도에서 손상을 식별 가능한 충분한 품질을 얻어낼 수 있었으나 스마트폰의 전용 어플리케이션과 RTMP 서버 간의 통신 지연 그리고 서버의 처리 속도 한계로 인해 실제 촬영 영상이 서버 쪽 영상에서 2~5초 정도 지연이 발생했다. 이는 학습된 인공지능 모델인 l과 n 모델의 추론 처리 속도와는 관계없이 지연된 영상을 보여주었다.

Realwear는 GoPro와 마찬가지로 라우터를 통해 연결된 네트워크로 TEAMS의 모임 기능을 통해 검사원들 간 쌍방향 커뮤니케이션을 테스트했다. 실시간 영상의 품질은 해당 어플리케이션 설정에 종속되어 통신 속도에 따른 영상 품질의 변화를 확인할 수 있었다. 일반적인 대화, 구조물 식별, 경고문 확인 등에는 문제가 없었으나, Realwear와 TEAMS의 호환성 문제로 확대, 축소, 조명 기능 활용이 원활하지 못한 경우가 발생했다. 인공지능을 이용한 추론은 저장된 검사 영상 데이터로 수행되었으며 이 경우 통신 속도에 영향을 받지 않아 안정적인 객체 탐지 성능을 보여주었다. 결과적으로 모든 테스트 시나리오는 Fig. 11에서 볼 수 있듯 균열 손상을 탐지해냈다. 하지만 균열 손상이 아닌 구역에서 confidence score가 낮지만, 균열로 판단하여 탐지하는 등의 상황이 발생했다. 또한 네트워크 속도에 따른 영상 품질 문제가 존재하며 실시간 영상에 인공지능 적용 시 수신되는 데이터 속도에 영향을 받는 것을 확인할 수 있었다. 원활한 인공지능 활용 검사 및 원격 검사 등을 수행하기 위해선 모바일 라우터 이상의 안정적인 통신 성능을 보장하는 네트워크 장비가 필요하고, 영상 처리 서버의 가용성도 중요한 사양임을 확인했다. 검사 현장에서 수집되는 데이터의 품질과 통신 속도에 따라 인공지능 원격 검사 적용 가능성이 변동되며 이는 하드웨어와 소프트웨어 사이를 유기적으로 연동할 수 있는 적절한 기술개발이 필요함을 알 수 있다.

5. 결 론

이 연구를 통한 결론은 아래와 같다.

- (1) 선체 손상을 다양한 자료와 전문가들의 의견에 근거하여 균열, 부식, 변형, 그 외, 점식, 찍힘 6종으로 분류하고 선체 손상 데이터셋을 구축했다.

- (2) 선체 손상 중 균열 손상에 대하여 1,360장을 수집하고 labeling을 통해 ‘일반 선체 균열 데이터셋’을 구축했다.

- (3) 인공지능 기반 균열 탐지를 위해 YOLOv5 모델 5종(x, l, m, s, n)을 학습하고 성능 비교를 통해 정확성과 효율성 측면에서 l 모델과 n 모델을 제시했다.

- (4) 검사 현장에서 사용 가능한 장비 2종(GoPro, Realwear)을 선정하고 실시간 영상의의 인공지능 균열 탐지 적용과 저장된 검사 영상에 인공지능 균열 탐지 적용 두 개의 시나리오를 테스트하고 현장 적용성을 검토했다.

- (5) 실시간 영상을 활용한 원격 검사 시 안정적인 통신 환경과 프로토콜 전송 서버의 가용성이 검사 환경에 큰 영향이 있음을 확인했다.

인공지능 객체 탐지 성능은 기대 이상의 결과를 보여주었으나, 정확도에서 부족함을 보였다. 이는 모델 구조와는 별개로 학습 데이터셋의 규모와 다양성이 부족한 것으로 추후 데이터 개수 증가, 세부 균열 class 분류와 labeling 등 데이터 품질 증가로 개선할 수 있을 것으로 판단된다.

실제 검사 현장에서는 통신 상태에 따라 영상의 품질이 달라졌고, 음영 구역이 존재하여 실시간 스트리밍이 원활하지 못했다. 또한 어플리케이션에 종속적인 기능으로 인해 장비 자체의 기능을 충분히 활용하지 못하는 경우도 발생했다. 무엇보다 통신 환경의 제약으로 원활한 성능 유지가 어렵다는 점에서 개선점이 필요하다. 5G를 사용하더라도 음영 구역은 피할 수 없었으며, 철판으로 이루어진 선체 특성상 전파의 송수신 정도가 약하다. 따라서 이러한 환경을 극복하기 위해 중계기 또는 별도의 증폭기가 필요하다. 큰 선박의 열려있는 공간에서는 이러한 제약 사항이 완화되어 실시간 스트리밍은 가능하겠지만, 작은 선박의 경우 협소한 공간과 통신 상황을 개선할 수 있는 해결책이 필요하다. 그러므로 모든 선체 검사 현장에 같은 범용 장비를 사용하는 것보다는 선종과 크기, 검사 현장 등에 따라 적합한 장비와 검사 방법 프로세스를 구축하는 것이 중요하다고 판단된다.

Acknowledgments

이 논문은 2022년도 해양수산부 및 해양수산과학기술진흥원 연구비 지원으로 수행된 '자율운항선박 기술개발사업(20200615)'의 연구결과입니다.

References

- Bochkovskiy, A., Wang, C.Y. and Liao, H.Y.M., 2020. Yolov4: Optimal speed and accuracy of object detection arXiv preprint arXiv:2004.10934. [Online] (Updated 23 Apr 2020) Available at: https://doi.org/10.48550/arXiv.2004.10934, [Accessed 12 Apr 2022].

- International Association of Classification Societies (IACS), 2019. No.96 Double Hull Oil Tankers Guidelines for Surveys, Assessment and Repair of Hull Structures, IACS

- International Association of Classification Societies (IACS), 2020. Z7 Rev.28 Hull Classification Surveys, IACS.

- International Ship and Offshore Structures Congress (ISSC), 2009, ISSC Committee V.1: Damage Assessment After Accidental Events, Korea: ISSC

-

Kim, B. and Cho, S., 2018. Automated vision-based detection of cracks on concrete surfaces using a deep learning technique. Sensors, 18(10), pp.3452.

[https://doi.org/10.3390/s18103452]

- Korean Register (KR), 2022a. Guidance for Remote Inspection Techniques, Korea: KR.

- Koran Register (KR), 2022b. Guidance for Remote Survey, Korea: KR.

-

Liu, Z., Cao, Y., Wang, Y. and Wang, W., 2019. Computer vision-based concrete crack detection using U-net fully convolutional networks. Automation in Construction, 104, pp.129-139.

[https://doi.org/10.1016/j.autcon.2019.04.005]

-

Ortiz, A., Bonnin-Pascual, F., Garcia-Fidalgo, E. and Company-Corcoles, J.P., 2016. Vision-based corrosion detection assisted by a micro-aerial vehicle in a vessel inspection application. Sensors, 16(12), pp.2118.

[https://doi.org/10.3390/s16122118]

-

Poggi, L., Gaggero, T., Gaiotti, M., Ravina, E., and Rizzo, C. M., 2020. Recent developments in remote inspections of ship structures. International Journal of Naval Architecture and Ocean Engineering, 12, pp.881-891.

[https://doi.org/10.1016/j.ijnaoe.2020.09.001]

- Wang, C.Y., Yeh, I.H. and Liao, H.Y.M., 2021. You only learn one representation: Unified network for multiple tasks arXiv preprint arXiv:2105.04206. [Online] (Updated 10 May 2021) Available at: https://doi.org/10.48550/arXiv.2105.04206, [Accessed 12 Apr 2022].

-

Xie, J., Stensrud, E., and Skramstad, T., 2021. Detection-based object tracking applied to remote ship inspection. Sensors, 21(3), pp.761.

[https://doi.org/10.3390/s21030761]

- YOLOv5, 2022, [Online] (Updated 12 Oct 2021) Available at: https://github.com/ultralytics/yolov5, [Accessed 12 Apr 2022].