이미지 인페인팅을 활용한 레이다 이미지 노이즈 제거

This is an Open-Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License(http://creativecommons.org/licenses/by-nc/3.0) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

Abstract

Marine environment analysis and ship motion prediction during ship navigation are important technologies for safe and economical operation of autonomous ships. As a marine environment analysis technology, there is a method of analyzing waves by measuring the sea states through images acquired based on radar(radio detection and ranging) signal. However, in the process of deriving marine environment information from radar images, noises generated by external factors are included, limiting the interpretation of the marine environment. Therefore, image processing for noise removal is required. In this study, image inpainting by partial convolutional neural network model is proposed as a method to remove noises and reconstruct radar images.

Keywords:

Image inpainting, Radar image, Partial convolutional neural network키워드:

이미지 인페인팅, 레이다 이미지, 부분 합성곱 신경망1. 서 론

1.1 연구 배경 및 필요성

해양 기상은 선박의 안전에 영향을 미치고, 경제적인 운항을 결정하는 데에 중요한 요소이기 때문에, 이를 파악하는 것은 선박 운항을 스스로 제어하는 자율운항 기술에 필수적으로 선행되어야 하는 연구 중 하나이다. 최근에는 4차 산업과 관련하여 각종 카메라, 레이다와 같은 센서들과 ICT(Information Communication Technology) 기술이 접목된 해상 상태 정보 수집에 관한 연구가 이루어지고 있고 (Seol, 2018), 레이다 이미지 또한 해상환경 정보를 담고 있으나, 획득한 레이다 이미지에 나타나는 노이즈로 인해 이미지가 손상되거나 파랑을 제외한 해상에 존재하는 선박과 같은 부유체 및 객체(부표, 육지, 섬, 기타 장애물 등)에 의해 명확하고 정확한 분석을 할 수 없게 되는 경우가 발생한다. 이 때문에 효과적인 해상환경 예측을 위해서 레이다 이미지상에 존재하는 해상정보가 아닌 부분들을 제거하고, 제거된 자리를 주변 이미지와 부합되도록 복원하는 이미지 재생산에 대한 전처리 과정이 필요하다.

1.2 관련 연구 현황

인페인팅(Inpainting)은 이미지의 특징들을 추출해 가려진, 혹은 보이지 않는 부분을 복원, 생성해 내는 것으로 고문서 복원, 손상 데이터 복구 등, 다양한 분야에서 오랫동안 연구되었다. 최근에는 컴퓨터 하드웨어의 발달로 이전에는 구현할 수 없었던 신경망 학습을 이용한 인페인팅 기법에 관한 연구가 이루어지고 있다.

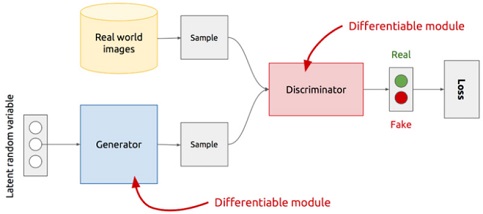

2014년도에 Ian. j. Goodfellow에 의해 발표된 생성적 적대 신경망(GAN)에 대한 개념을 이용하여, 이미지에 비워진 부분을 서로 경쟁하는 두 개의 네트워크 시스템에 의해 인페인팅하는 기술이 연구되었다 (Yeh et al., 2017). GAN(Generative Adversarial Networks)은 Fig. 1에서 볼 수 있듯이 생성기(generator)와 판별기(discriminator)로 두 개의 네트워크를 구성하는데, 생성기는 실제 데이터의 확률 밀도 함수를 이용해 가짜 데이터를 만들고, 판별기는 가짜 데이터를 진짜인지 가짜인지 구별하는 역할을 맡고 있다. 여기서 판별기는 어느 것이 진짜 이미지인지 알고 있기 때문에, 지도학습과 같은 방향으로 학습을 하고, 생성기는 판별기를 속일 수 있는 방향으로 서로 경쟁적으로 학습해 결국 생성기는 판별기를 속일 수 있을 정도의 가짜 데이터를 만들어 낼 수 있게 되며, 판별기 또한 판별하는 능력이 점차 개선되는 방식이다. 기존 신경망과의 차이점은 GAN은 생성기와 판별기 모두 학습이 필요하므로 두 개의 손실 함수(loss function)가 필요하다.

2018년도에는 엔비디아(NVIDIA)에서 Guilin Liu가 이끌고 있는 연구진이 임의로 이미지의 컨텐츠를 삭제하고 인페인팅하는 기술에 대해 연구하였다 (Liu et al., 2018). 이 연구는 부분 합성곱 신경망(partial convolutional neural network)을 기반으로 이루어졌는데, 이는 학습 시 마스크 이미지도 입력값으로 들어가는 점이 기존 신경망을 이용한 인페인팅과 차이가 있다. 부분 합성곱 신경망을 통해 구현한 인페인팅 기법은 불규칙하고 큰 손상부도 어느 정도 높은 정확도로 재구성할 수 있는 특징이 있다. 본 논문에서는 노이즈가 있는 레이다 이미지 전처리에 Liu (2018)가 제안한 부분 합성곱 신경망을 적용하는 연구를 수행하였다.

2. 이미지 인페인팅 기법

인페인팅의 공통적인 개념은 손상된 부위의 주변 요소에 대한 특징을 추출하여 이를 바탕으로 그 부위를 재구성하는 것이다. 기존에는 손실된 영역의 외부에서 내부의 방향으로 영상 라플라시안을 확산시키는 방식인 확산 기반 방법(diffusion-based image inpainting)과 손실되지 않은 영역에서 손실된 영역에 가장 적절한 패치를 복사하여 복원하는 예제 기반 방법(exemplar-based image inpainting)이 대표적인 인페인팅 기법이었다 (Baek et al., 2016). 인텔에서 개발한 컴퓨터 비전 목적의 프로그래밍 라이브러리인 OpenCV에 포함되어있는 인페인팅 함수도 이 예제 기반 방법으로 구현되어 있어 다양한 프로그래밍 언어로 간단하게 인페인팅을 할 수 있다. 하지만 기존의 인페인팅 방법은 전체 이미지 픽셀의 흐름을 반영하지 못하고, 손상된 부위의 면적이 큰 경우에 원본 이미지를 정확하게 예측하는 데에 한계가 있다.

2010년도부터는 기계 학습을 사용한 초기 인페인팅의 개발이 이루어지면서 면적이 큰 손상 부위를 복원하는 문제가 어느 정도 해소되었지만, 손상 부위의 모양이 사각형인 경우에 학습이 이루어지도록 맞춰져 있어 불규칙한 형상의 결함부를 가진 이미지 데이터의 복원된 모습을 예측하는 것이 어렵다. 따라서, 크고 불규칙한 손상을 인페인팅할 수 있는 모델이 필요하다.

3. 부분 합성곱을 이용한 이미지 인페인팅

3.1 레이다 이미지

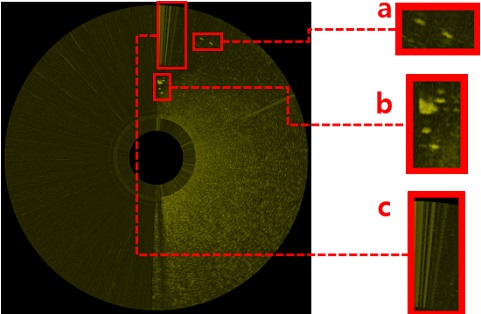

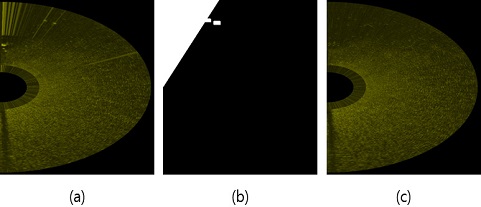

본 연구에 사용된 이미지 데이터는 1104X1104픽셀 크기의 X 밴드 레이다 이미지로, 낮과 밤에 상관없이 대부분의 기상 조건에서 센서인 X 밴드 레이다가 해양 표면의 후방 산란을 측정하여 시간과 공간에 따른 파의 높이를 Fig. 2와 같이 스캔한다(Dankert et al., 2004). 학습에 사용된 레이다 이미지는 해안에서 측정되었기 때문에 왼쪽 절반은 육지여서 후에 전처리 과정에서 제거된다. 레이다 이미지에 측정된 내용 중 해수면이 아닌 것에 대해 크게 Fig. 2와 같이 a, b, c 세 가지로 분류된다. a는 시간에 따라 이동하는 물체(선박 등), b는 시간이 지나도 위치가 장시간 고정돼있는 물체(섬, 해양구조물 등), 그리고 c는 크기가 큰 물체로 인해 물체 뒤에 송수신이 정확히 이루어지지 않아 나타나는 부위로, Fig. 2의 경우 b로 인해 발생한다.

3.2 노이즈 정의

데이터상에 노이즈는 연구의 목적에 따라 다르게 정의될 수 있다. 예를 들어, 해상에 있는 객체를 인식하는 연구에서는 레이다 이미지상에 선박, 섬 등이 필수적인 요소라 노이즈라 할 수 없지만, 레이다 이미지를 통해 파도의 높이를 측정하여 이에 대응하는 복원성 및 경제적인 선박 운항을 확보하는 연구에서는 해수면 자료 외에 다른 정보가 필요 없으므로 나머지는 노이즈가 된다. 본 연구에서는 서론에서 언급한 연구 목표에 따라 해양 표면이 아닌 것을 나타내는 Fig. 2의 a, b, c를 노이즈로 정의하였다.

3.3 노이즈 탐색

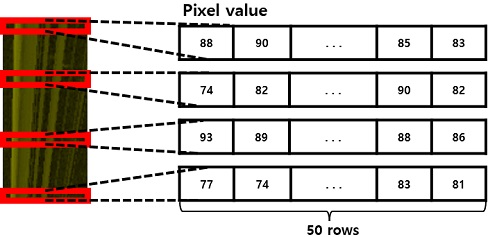

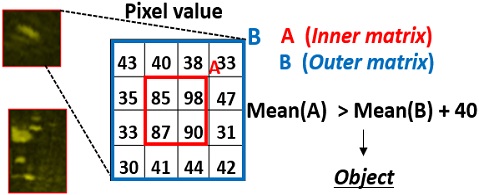

앞서 결정한 노이즈의 정의를 바탕으로 노이즈의 특성을 정리한 결과, Fig. 2의 a와 b는 밝은 픽셀이 주변 지역보다 밀집해 있는 형상을 하고, Fig. 2의 c가 레이다 이미지상에서 나타나는 경우 항상 고정된 위치(b의 상부)에만 나타나며 주변에 비해 현저히 밝다는 것을 확인하였다. 레이다 이미지상에서 노이즈 탐색을 위한 알고리즘을 구현하기 위해 1104X1104 크기의 레이다 이미지를 1104X1104의 정수행렬로 변환하고 각 행렬의 요소를 픽셀의 밝기값 0~255로 구성하도록 설정하였다. 행렬로 변환된 이미지를 앞서 확인한 노이즈의 특성에 맞게 Fig. 3과 같이 이미지상에 고정 위치 네 군데를 1X50 크기 행렬의 픽셀로 고정 위치마다 읽어 행렬의 픽셀값(밝기)의 합이 네 군데 모두 4,200 이상일 경우에 c(레이다 송수신이 불가한 위치)로 인식하도록 설계하였다. 여기서 임계값을 4,200으로 선정한 이유는 c가 포함된 레이다 이미지들을 모두 종합하여 이미지마다 고정 위치에 있는 각 행렬의 합들을 확인하였을 때 가장 작은 값이 4,200였기 때문이다. a(해상에 이동하는 물체)와 b(해상에 고정된 물체)에 대해서는 Fig. 4와 같이 1104X1104의 정수화된 이미지 행렬을 하나의 작은 행렬인 외부행렬(outer matrix) B 단위로 왼쪽 위에서 출발하여 오른쪽 아래로 읽어나갈 때, 외부행렬 B 안쪽에 내부행렬(Inner matrix) A의 픽셀 평균값이 외부행렬 B의 픽셀 평균보다 최소 40 이상 더 크면 인식하게 알고리즘을 구성했다. 여기서 최솟값 40은 시행착오를 통해 찾아낸 값이다.

3.4 라벨, 마스크 이미지 생성

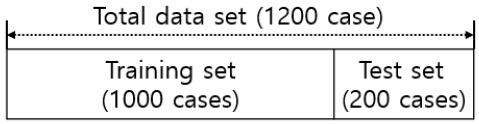

이미지 학습을 위해, 육지인 이미지의 왼쪽 반원 부분은 필요하지 않기 때문에 제거하였다. 학습에 필요한 입력 데이터로 쓰이는 라벨 이미지와 마스크 이미지를 준비하였고, 학습 후 테스트에 사용될 GT(Ground Truth) 이미지와 마스크 이미지를 생성했다. 라벨 이미지는 학습을 할 때 개발자가 원하는 모범 답안과 같은 역할을 하는 이미지로, 본 연구에서는 노이즈가 전혀 없는 이미지이다. 라벨 이미지를 생성하기 위해 반원 레이다 이미지로부터 노이즈 부분만을 제거하고, 바로 이웃한 부위의 픽셀값을 가져와 손실된 곳을 Fig. 5의 (c)와 같이 인위적으로 복원하였다. 마스크 이미지는 노이즈 부위를 흰색(픽셀값 1), 그 외는 검은색(픽셀값 0)으로 나타내어진 이미지이고, GT 이미지는 테스트에 사용될 노이즈가 포함된 이미지다. 생성한 데이터의 구성은 라벨 이미지와 마스크 이미지의 쌍으로 1,000개의 트레이닝 세트(training set), GT 이미지와 마스크 이미지의 쌍으로 200개의 테스트 세트(test set)를 Fig. 6과 같이 설정하였다.

3.5 부분 합성곱 신경망

기존의 합성곱과 부분 합성곱 신경망은 구조가 거의 일치하지만 마스크 단계의 유무에 따라 용도의 차이가 나뉜다. 부분 합성곱은 입력값으로 라벨 이미지와 마스크 이미지가 함께 들어가기 때문에, 이미지 분할, 분류 등에 적합한 일반 합성곱 신경망보다 이미지 인페인팅에 적합하다. 부분 합성곱 신경망은 식 (1)과 같이 정의된다. 여기서 X는 라벨 이미지, M은 마스크 이미지, W는 학습 가중치(weight), 그리고 b는 편향(bias)이다.

| (1) |

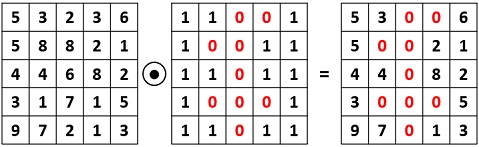

라벨 이미지(X)와 마스크 이미지(M)를 아다마르 곱(Hadamard product)을 통해 결합한 이미지가 가중치(W)와 스케일링(sum (1)/sum (M), 편향 (b)를 통해 학습이 이루어진다 (Liu et al., 2018). 아다마르 곱이란 Fig. 7과 같이 같은 크기의 두 행렬의 각 성분을 곱하는 연산으로 마스크 이미지(M)가 0과 1만으로 구성된 바이너리 이미지이기 때문에 라벨 이미지(X)와 아다마르 곱을 통해 지우고자 하는 부분의 픽셀값을 0으로 처리할 수 있다.

기존 부분 합성곱 신경망은 랜덤 마스크 이미지를 생성하여 아다마르 곱을 하지만, 본 연구에서는 레이다 노이즈에 대한 정의가 분명하게 이루어졌고 노이즈가 이미지 전체에서 일부분만 존재하기 때문에, 노이즈 탐색을 통해 미리 생성해둔 마스크 이미지를 사용하여 높은 정확도를 목표로 학습을 수행하였다.

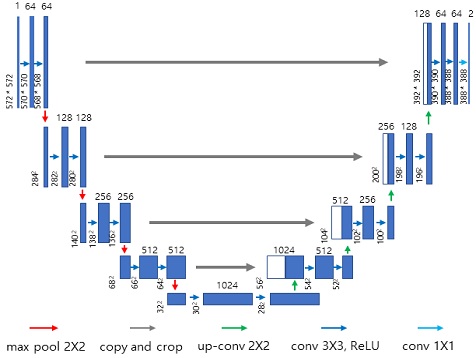

3.6 U-Net Architecture

레이다 이미지 인페인팅에 사용된 신경망은 U-Net (Convolutional networks for biomedical image segmentation) 아키텍처(Architecture)이다. U-Net 아키텍처는 주로 이미지 분할이나 분류에 사용되는 엔드-투-엔드(End-to-end) 방식의 FCN(Fully Connected Layer)기반 모델로 학습 속도가 빠르고, 이미지 일부를 보고 전반적인 이미지의 문맥(context)을 파악하는 능력이 뛰어나며, 이미지 안에 객체가 어디 있는지 찾아내는데에도 효과적이다 (Ronneberger et al., 2015). 구성은 Fig. 8 같이 왼쪽 절반은 인코딩(encoding) 과정인 수축 단계(contracting path)가 가로 방향으로 진행되는 합성곱층(convolutional layer)과 세로 방향으로 진행되는 풀링층(pooling layer)으로 이루어져 있고, 오른쪽 절반은 디코딩(decoding) 과정인 팽창 단계(expanding path)로 수축 단계와 대칭이며 수축 단계의 역으로 진행된다. 본 연구에서는 U-Net 아키텍처에 사용된 합성곱 층을 모두 부분 합성곱층으로 바꾸고, 디코딩 과정에서 데이터를 그대로 늘려서 확장된 빈 구역에 채워 넣는 Nearest neighbor upscaling 을 적용했다.

3.7 손실 함수(Loss function)

정확한 이미지 인페인팅을 위해, 주로 사용하는 평균 제곱 오차(MSE), 평균 제곱근 오차(RMSE)가 아닌 결함 주변 픽셀의 문맥(context)을 반영하는데 필요한 조건들을 고려하여 손실 함수를 식 (2) 와 같이 설정하였다 (Liu et al., 2018). 그리고 식 (2)를 구성하는 loss(L)들에 대한 정의를 식 (3) ~ (8)으로 나타냈다. 식 (3) ~ (8)에 사용되는 변수들은 Table 1과 같고 I는 세부적으로 라벨 이미지에 결함을 낸 입력 이미지 Iin, 라벨 이미지 Igt, 신경망을 통해 예측한 이미지를 Iout, 그리고 Iin에서 결함이 아닌 부위만을 Iout로부터 가져와 생성한 이미지인 Icomp로 구별된다.

| (2) |

식 (2) 를 구성하는 각각의 loss(L) 값 중, 식 (3)은 손상되지 않은 부분을 의미하는데, 이 식에서 NIgt는 라벨 이미지의 행(H), 열(W), 그리고 채널 수(C)를 곱한 값이다. 그리고 식 (4)는 손상된 부분을 얼마나 정확히 복원했는지에 대한 loss를 의미한다. 손상되지 않은 부분의 전체 스타일에 대해서는 식 (5)와 (6)을 통해 오차를 줄이는데 Ψ는 이미지에 activation map을 씌워서 나오는 결과를 표현한 기호이다.

| (3) |

| (4) |

| (5) |

| (6) |

비슷한 맥락으로 모델에서 도출된 Iout은 손상되지 않은 부분도 라벨 이미지와 비교했을 때 다를 수 있으므로, 이 부분 또한 Icomp과의 계산을 통해서 정확도를 높여야 한다. 이는 식 (7)을 통해서 수행한다. 마지막으로 복원 부위와 배경이 원활하게 이어지도록 픽셀과 전체 영역의 차이를 하나의 손실로 지정하여 식 (8)과 같이 구성하였다. 여기서 R은 한 픽셀의 전체 영역에 대한 팽창 범위다.

| (7) |

| (8) |

4. 결 과

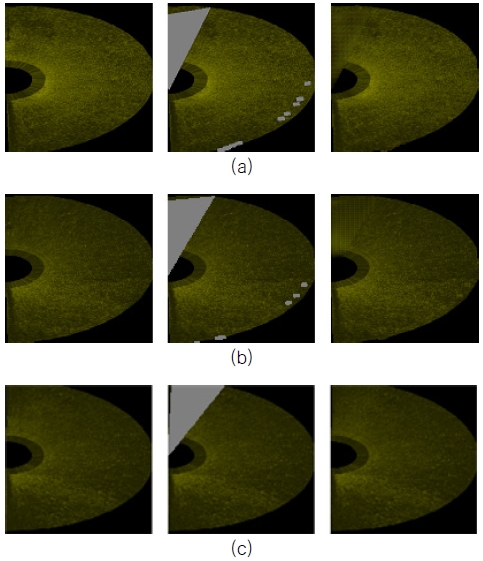

4.1 신경망 학습

생성된 라벨 이미지와 마스크 이미지를 입력값으로 하여 부분 합성곱 신경망을 통해 1,000개의 데이터를 총 375,000 iteration, 1,500 epochs로 설정하여 학습시켰다. Fig. 9은 학습이 이루어지는 과정을 몇 개의 샘플을 통해 시각화한 것으로 첫 번째 열은 입력값으로 들어간 라벨 이미지, 두 번째 열은 마스크와 라벨이 결합 된 이미지. 세 번째는 부분 합성곱 신경망으로 복원된 이미지를 나타낸다. 학습 초기인 (a)에서 점차 (c)로 학습이 진행되면서 마스크에 의해 손상된 이미지가 라벨 이미지에 가깝게 복원된 것을 볼 수 있다.

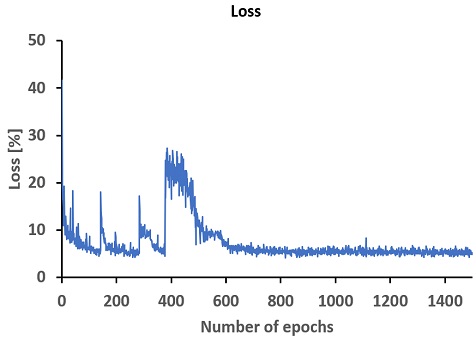

3.7 장에 식 (2)에서의 loss 계산 방법을 반영하여 전반적인 학습 과정에서의 loss 값을 epoch마다 Fig. 10과 같이 나타낸 결과, epoch가 진행되면서 loss가 5~6% 사이로 수렴하였다.

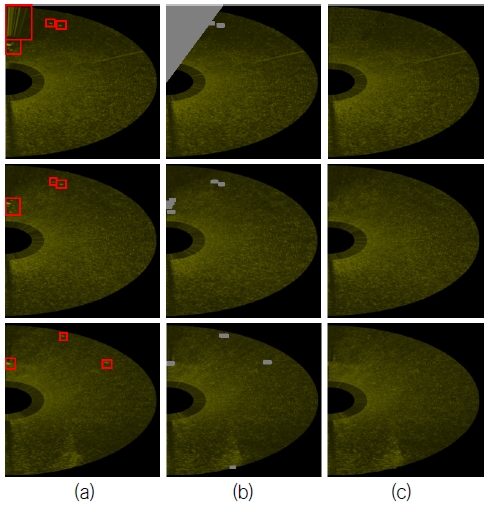

4.2 시험 데이터 추정

트레이닝 세트를 통해 학습한 신경망으로, 본 연구에서는 노이즈가 있는 원본 사진과 원본 사진의 노이즈 부분만을 탐색해 만든 마스크 이미지 200쌍의 테스트 세트로부터 마스크 부분을 지우고 결함부의 이미지 복원을 수행하였으며, Fig. 11과 같은 결과를 얻었다. 첫 번째 열은 노이즈가 존재하는 원본 레이다 이미지, 두 번째 열은 노이즈 부분만을 탐색해서 마스크로 지워낸 이미지이고 세 번째 열은 학습을 바탕으로 지워진 부분을 테스트를 통해 복원한 이미지이다.

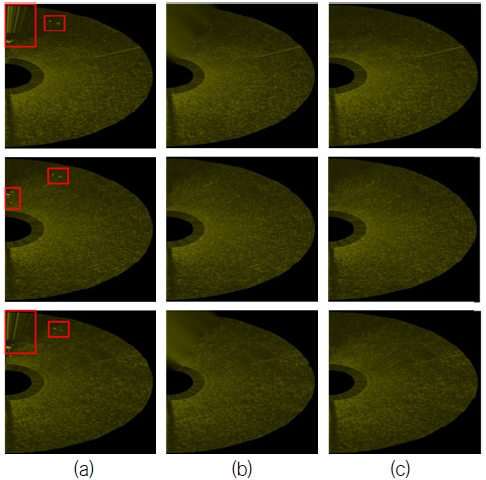

테스트 결과에 대한 성능을 확인하기 위해 본 논문 2장에서 언급한 예제 기반 방법의 인페인팅이 구현된 OpenCV로 이미지를 복원하여 테스트를 통해 복원된 이미지들과 비교하였다. Fig. 12에 (b) 열은 OpenCV, (c) 열은 부분 합성곱 신경망으로 복원된 이미지이다. Fig. 12에 나타난 결과를 3장에서 정의한 노이즈를 참고하여 비교했을 때, 두 번째 행과 같이 노이즈가 해상에서 이동하거나 고정된 물체만 있는 경우 마스크 이미지를 통해 제거하는 부위가 작으므로 인페인팅하는데 두 방법 간에 차이가 없다. 하지만 첫 번째와 세 번째 행에서 입력 이미지(a)의 좌측 상단처럼 송수신 불량으로 인해 나타나는 노이즈(Fig. 2의 c)가 포함된 경우, 제거하는 부위가 커지기 때문에 OpenCV를 이용한 인페인팅 방법은 복원된 부위가 흐려지는 것을 볼 수 있다.

5. 결 론

본 연구에서는 해상 상태를 분석하기 전, 레이다 이미지상에 존재하는 노이즈를 제거하고 인페인팅하는 전처리 방법을 부분 합성곱 신경망 학습을 적용하여 수행하였다. 학습을 위한 사전 준비로 노이즈 탐색 방법을 레이다 이미지에 적용할 수 있도록 알고리즘을 개발하였고, 다양한 형상의 결함부에 최적화되어 있는 학습 모델을 채택하였다. 라벨 이미지와 마스크 이미지에 대한 학습 후 테스트 결과, 예제 기반 인페인팅 방법을 사용한 OpenCV 라이브러리와 비교하였을 때 크고 불규칙한 노이즈의 인페인팅에 대해서 부분 합성곱 신경망을 통한 인페인팅 방법이 이미지 전체에 대한 맥락을 반영하는 데에 있어 우수했다. 예제 기반 인페인팅은 수식을 통한 주변 픽셀값의 확장으로 이미지 결함부를 채우는 데 반해, 부분 합성곱 신경망은 loss에서 원본 이미지와의 비교, 결함부 주변의 맥락, 이미지 전체의 반영 등이 이루어진다는 점에서 결과에 차이가 나타났다.

라벨 이미지, 마스크 이미지 데이터 세트를 생성하기 위해 3.2장에 설명된 노이즈 인식 알고리즘을 실행하는 과정에서, 1200장의 데이터 세트 중 몇 안 되는 이미지에서 노이즈가 아닌 부분도 정의된 노이즈의 특성을 만족하면 노이즈로 인식하는 현상이 드물게 나타났다. 데이터를 기반으로 학습이 이루어지는 기계 학습의 특성상 부정확한 데이터가 학습에 반영이 되면 해당 내용이 학습과 테스트에 반드시 영향을 미치기 때문에, 보다 정교한 방법으로 노이즈를 탐색하는 알고리즘을 연구를 진행하고자 한다.

Acknowledgments

본 논문은 2022년도 해양수산부 및 해양수산과학기술진흥원 연구비 지원으로 수행된 '자율운항선박 기술개발사업(20200615)'의 연구결과입니다.

References

- Baek, J.Y., Chung, B.J. & Yim, C.H., 2016. Removal of objects in digital image by double exemplar-based image inpainting. Proceedings of Korean Institute of Information Scientists and Engineers winter Conference, Pyeongchang, Republic of Korea, 1721-1723 December 2016.

-

Dankert, H. & Rosenthal, W., 2004. Ocean surface determination from X-band radar-image sequences. Journal of Geographical Research, 109(C4), pp.1-11

[https://doi.org/10.1029/2003JC002130]

-

Liu, G., Reda, F. A., Shih, K. J., Wang, T. C., Tao, A. & Catanzaro, B., 2018. Image inpainting for irregular holes using partial convolutions. Proceedings of the European Conference on Computer Vision, Munich, Germany, 85-100 September 2018.

[https://doi.org/10.1007/978-3-030-01252-6_6]

-

Ronneberger, O., Fischer, P. & Brox, T., 2015. U-net: Convolutional networks for biomedical image segmentation. Proceedings of International Conference on Medical Image Computing and Computer-Assisted Intervention, Munich, Germany, 234-241 October 2015.

[https://doi.org/10.1007/978-3-319-24574-4_28]

- Seol, D.I., 2018. Research on the influence of ocean weather on autonomous ship. Proceedings of Korean Society of Marine Environment and Safety biannual meeting, Incheon, Republic of Korea, 78-78 June 2018.

-

Yeh, R.A., Chen, C., Yian Lim, T., Schwing, A.G., Hasegawa-Johnson, M. & Do, M.N., 2017. Semantic image inpainting with deep generative models. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, HI, USA, 5485–5493 July 2017.

[https://doi.org/10.1109/CVPR.2017.728]